莫烦Python 4

2024-09-08 18:03:03

莫烦Python 4

新建模板小书匠

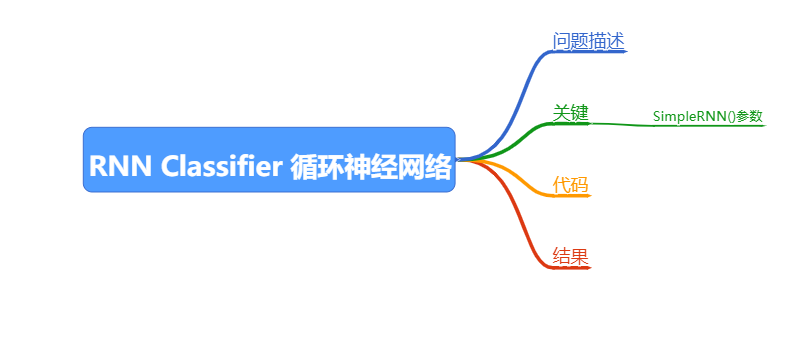

RNN Classifier 循环神经网络

问题描述

使用RNN对MNIST里面的图片进行分类

关键

SimpleRNN()参数

- batch_input_shape

使用状态RNN的注意事项

可以将RNN设置为‘stateful’,意味着由每个batch计算出的状态都会被重用于初始化下一个batch的初始状态。状态RNN假设连续的两个batch之中,相同下标的元素有一一映射关系。

要启用状态RNN,请在实例化层对象时指定参数stateful=True,并在Sequential模型使用固定大小的batch:通过在模型的第一层传入batch_size=(…)和input_shape来实现。在函数式模型中,对所有的输入都要指定相同的batch_size。

如果要将循环层的状态重置,请调用.reset_states(),对模型调用将重置模型中所有状态RNN的状态。对单个层调用则只重置该层的状态。

(samples,timesteps,input_dim)

代码

'''

RNN Classifier 循环神经网络

'''

import numpy as np

np.random.seed(1337)

from keras.datasets import mnist

from keras.utils import np_utils

from keras.models import Sequential

from keras.layers import SimpleRNN, Activation, Dense

from keras.optimizers import Adam

time_step = 28

input_size = 28

batch_size = 50

output_size = 10

cell_size = 50

LR = 0.001

(X_train, y_train), (X_test, y_test) = mnist.load_data()

X_train = X_train.reshape(-1, 28, 28) / 255. # normalize

X_test = X_test.reshape(-1, 28, 28) / 255. # normalize

y_train = np_utils.to_categorical(y_train, num_classes=10)

y_test = np_utils.to_categorical(y_test, num_classes=10)

model = Sequential()

model.add(

SimpleRNN(

batch_input_shape=(None, time_step, input_size),

units=cell_size

)

)

model.add(

Dense(output_size)

)

model.add(Activation('softmax'))

adam = Adam(LR)

model.compile(

optimizer=adam,

loss='categorical_crossentropy',

metrics=['accuracy']

)

model.summary()

model.fit(X_train, y_train, batch_size=batch_size, epochs=2, verbose=2, validation_data=(X_test, y_test))

结果

Model: "sequential_2"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

simple_rnn_2 (SimpleRNN) (None, 50) 3950

_________________________________________________________________

dense_2 (Dense) (None, 10) 510

_________________________________________________________________

activation_2 (Activation) (None, 10) 0

=================================================================

Total params: 4,460

Trainable params: 4,460

Non-trainable params: 0

_________________________________________________________________

Train on 60000 samples, validate on 10000 samples

Epoch 1/2

- 12s - loss: 0.6643 - accuracy: 0.7966 - val_loss: 0.4501 - val_accuracy: 0.8550

Epoch 2/2

- 9s - loss: 0.3220 - accuracy: 0.9087 - val_loss: 0.2445 - val_accuracy: 0.9359最新文章

- [Django]用户权限学习系列之Permission权限基本操作指令

- wpf listview

- MVC - Action和ActionResult

- 【BZOJ 2434】【NOI 2011】阿狸的打字机 fail树

- MyBatis知多少(3)

- 开发报表时将已有User做成下拉列表,第一项为label为ALL,value为null

- aptana 插件离线下载方式

- 设计新Xlator扩展GlusterFS[转]

- mysql数据库小常识

- Python3 SMTP发送邮件

- 在CMD命令下安装nexus报错和启动的问题

- asp.net core webapi 生成导出excel

- 单片机成长之路(51基础篇) - 008 C51 的标示符和关键字

- jdbc链接数据库的url两种写法

- 【转】理解js中的原型链,prototype与__proto__的关系

- TCP拥塞控制-慢启动、拥塞避免、快重传、快启动

- Ie11 的改变

- LVS原理详解(3种工作方式8种调度算法)

- innodb索引统计信息

- Centos 安装ImageMagick 与 imagick for php步骤详解