3 pyspark学习---sparkContext概述

2024-09-27 02:30:15

1 Tutorial

Spark本身是由scala语言编写,为了支持py对spark的支持呢就出现了pyspark。它依然可以通过导入Py4j进行RDDS等操作。

2 sparkContext

(1)sparkContext是spark运用的入口点,当我们运行spark的时候,驱动启动同时上下文也开始初始化。

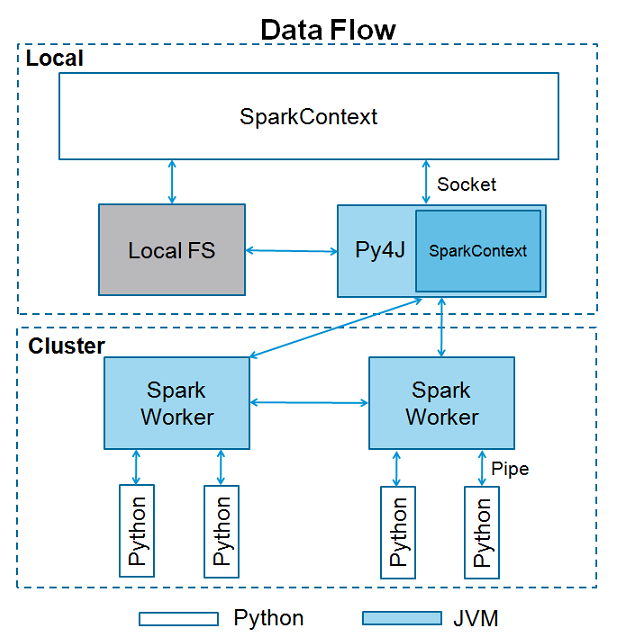

(2)sparkContext使用py4j调用JVM然后创建javaSparkContext,默认为‘sc’,所以如果在shell下就直接用sc.方法就可以。如果你再创建上下文,将会报错cannot run multiple sparkContexts at once哦。结构如下所示

(3)那么一个sparkContext需要哪些内容呢,也就是初始化上下文的时候类有哪些参数呢。

class pyspark.SparkContext (

master = None,#我们需要连接的集群url

appName = None, #工作项目名称

sparkHome = None, #spark安装路径

pyFiles = None,#一般为处理文件的路径

environment = None, #worker节点的环境变量

batchSize = 0,

serializer = PickleSerializer(), #rdd序列化器

conf = None,

gateway = None, #要么使用已经存在的JVM要么初始化一个新的JVM

jsc = None, #JavaSparkContext实例

profiler_cls = <class 'pyspark.profiler.BasicProfiler'>

)

尝试个例子:在pycharm中使用的哟

# coding:utf-8

from pyspark import SparkContext, SparkConf logFile = "./files/test.txt"

sc = SparkContext()

logData = sc.textFile(logFile).cache()

numA = logData.filter(lambda s: 'a' in s).count()

numB = logData.filter(lambda s: 'a' in s).count()

print "Lines with a: %i, lines with b: %i" % (numA, numB)

加油!

最新文章

- Angular.js内置的63个指令

- CSS选择器实现搜索功能 驱动过滤搜索技术

- Android 解析 xml

- [Effective C++ --019]设计class犹如设计type

- jsp判断手机访问和电脑访问

- KVC和KVO

- Python的经典问题——中文乱码

- iOS开发:后台运行以及保持程序在后台长时间运行

- 9.19.1 反射构造Class对象

- SpringMVC入门就这么简单

- overflow:hidden;和clear:both;的不同点

- [UnityShader基础]06.#pragma multi_compile

- day09 python之函数进阶

- [TYVJ1473]校门外的树3

- 关于“UI线程”

- 如何解决每次打开office 都会出现正在配置的问题

- IE6、IE7、Firefox中margin问题及input解决办法

- 【转载】QPS,用户平均等待时间,服务器平均请求处理时间

- Nastya Studies Informatics CodeForces - 992B(增长姿势)

- 【Unity笔记】摄像机、图片的模糊处理