Hadoop详解(09) - Hadoop新特性

Hadoop详解(09) - Hadoop新特性

Hadoop2.x新特性

远程主机之间的文件复制

- scp实现两个远程主机之间的文件复制

推 push:scp -r hello.txt root@hadoop103:/user/atguigu/hello.txt

拉 pull:scp -r root@hadoop103:/user/atguigu/hello.txt hello.txt

是通过本地主机:

通过本地主机中转实现两个远程主机的文件复制;如果在两个远程主机之间ssh没有配置的情况下可以使用该方式。

scp -r root@hadoop103:/user/atguigu/hello.txt root@hadoop104:/user/atguigu //是通过本地主机中转实现两个远程主机的文件复制;如果在两个远程主机之间ssh没有配置的情况下可以使用该方式。

- 采用distcp命令实现两个Hadoop集群之间的递归数据复制

[hadoop@hadoop102 hadoop-3.1.3]$ bin/hadoop distcp hdfs://hadoop102:9820/user/hadoop/hello.txt hdfs://hadoop105:9820/user/hadoop/hello.txt

小文件存档

- HDFS存储小文件弊端

每个文件均按块存储,每个块的元数据存储在NameNode的内存中,因此HDFS存储小文件会非常低效。因为大量的小文件会耗尽NameNode中的大部分内存。但注意,存储小文件所需要的磁盘容量和数据块的大小无关。例如,一个1MB的文件设置为128MB的块存储,实际使用的是1MB的磁盘空间,而不是128MB。

- 解决存储小文件办法之一

HDFS存档文件或HAR文件,是一个更高效的文件存档工具,它将文件存入HDFS块,在减少NameNode内存使用的同时,允许对文件进行透明的访问。具体说来,HDFS存档文件对内还是一个一个独立文件,对NameNode而言却是一个整体,减少了NameNode的内存。

- 案例实操

需要启动YARN进程

start-yarn.sh

归档文件

把/user/hadoop/input目录里面的所有文件归档成一个叫input.har的归档文件,并把归档后文件存储到/user/hadoop/output路径下。

hadoop archive -archiveName input.har -p /user/hadoop/input /user/hadoop/output

查看归档

hadoop fs -ls /user/hadoop/output/input.har

hadoop fs -ls har:///user/hadoop/output/input.har

解归档文件

hadoop fs -cp har:///user/hadoop/output/input.har/* /user/hadoop

回收站

开启回收站功能,可以将删除的文件在不超时的情况下,恢复原数据,起到防止误删除、备份等作用。

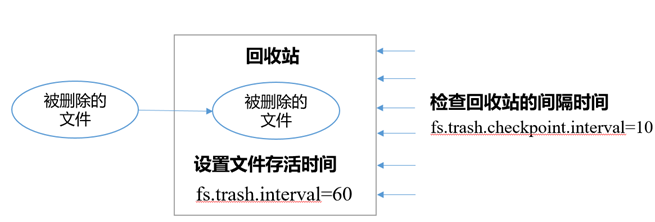

1)回收站参数设置及工作机制

- 开启回收站功能参数说明:

1、默认值fs.trash.interval=0,0表示禁用回收站;其他值表示设置文件的存活时间。

2、默认值fs.trash.checkpoint.interval=0,检查回收站的间隔时间。如果该值为0,则该值设置和fs.trash.interval的参数值相等。

3、要求fs.trash.checkpoint.interval<=fs.trash.interval。

- 回收站的工作机制

- 启用回收站

修改core-site.xml,配置垃圾回收时间为1分钟。

<property>

<name>fs.trash.interval</name>

<value>1</value>

</property>

<property>

<name>fs.trash.checkpoint.interval</name>

<value>1</value>

</property>

- 查看回收站

回收站目录在hdfs集群中的路径:/user/hadoop/.Trash/….

- 通过程序删除的文件不会经过回收站,需要调用moveToTrash()才进入回收站

Trash trash = New Trash(conf);

trash.moveToTrash(path);

- 通过网页上直接删除的文件也不会走回收站。

- 只有在命令行利用hadoop fs -rm命令删除的文件才会走回收站。

hadoop fs -rm -r /user/hadoop/input

2020-07-14 16:13:42,643 INFO fs.TrashPolicyDefault: Moved: 'hdfs://hadoop102:9820/user/hadoop/input' to trash at: hdfs://hadoop102:9820/user/hadoop/.Trash/Current/user/hadoop/input

- 恢复回收站数据

hadoop fs –mv /user/hadoop/.Trash/Current/user/hadoop/input /user/hadoop/input

Hadoop3.x新特性

多NN的HA架构

HDFS NameNode高可用性的初始实现为单个活动NameNode和单个备用NameNode,将edits复制到三个JournalNode。该体系结构能够容忍系统中一个NN或一个JN的故障。

但是,某些部署需要更高程度的容错能力。Hadoop3.x允许用户运行多个备用NameNode。例如,通过配置三个NameNode和五个JournalNode,群集能够容忍两个节点而不是一个节点的故障。

纠删码

HDFS中的默认3副本方案在存储空间和其他资源(例如,网络带宽)中具有200%的开销。但是,对于I/O活动相对较低暖和冷数据集,在正常操作期间很少访问其他块副本,但仍会消耗与第一个副本相同的资源量。纠删码(Erasure Coding)能够在不到50% 的数据冗余情况下提供和3副本相同的容错能力,因此,使用纠删码作为副本机制的改进是自然而然的。

查看集群支持的纠删码策略:hdfs ec -listPolicies

最新文章

- Const关键字

- STM32 CANBus RAM Layout

- 【转】linux下如何查看某个软件 是否安装?安装路径在哪

- C#学习笔记五: C#3.0Lambda表达式及Linq解析

- NSArray的排序

- 【UVA 10369】 Arctic Network (最小生成树)

- linux系统安装mysql

- python:前端(HTML)+后端(Django)+数据库(MySQL)

- [Swift]LeetCode187. 重复的DNA序列 | Repeated DNA Sequences

- iOS关键词weak和assign的区别

- Windows系统,文件和文件夹命名规则:

- python3+selenium框架设计06-编写POM测试用例

- 一脸懵逼学习oracle(图形化界面操作---》PLSQL图形化界面)

- Selenium + WebDriver 各浏览器驱动下载地址

- Zookeeper3.4.10 + ActiveMQ-5.15.0 集群搭建

- 喵哈哈村的魔法考试 Round #21 (Div.2) 题解

- 【delphi】关键字详解

- 玩转X-CTR100 l STM32F4 l DRV8825 A4988 步进电机控制

- Musle比对软件

- (转)编码规范系列(一):Eclipse Code Templates设置