CNN 卷积神经网络结构

cnn每一层会输出多个feature map, 每个Feature Map通过一种卷积滤波器提取输入的一种特征,每个feature map由多个神经元组成,假如某个feature map的shape是m*n, 则该feature map有m*n个神经元。对于卷积层会有kernel, 记录上一层的feature map与当前层的卷积核的权重,因此kernel的shape为(上一层feature map的个数,当前层的卷积核数)。

CNN网络结构

一种典型卷积网络结构是LeNet-5,用来识别数字的卷积网络。结构图如下(来自Yann LeCun的论文):

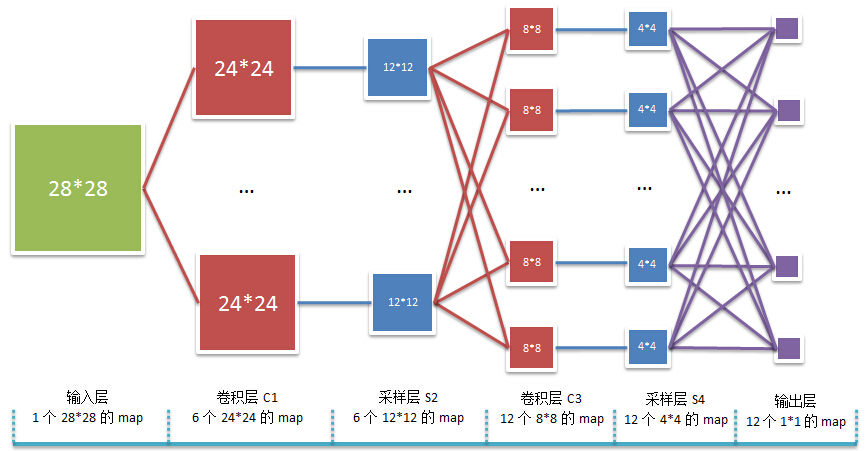

在卷积神经网络算法的一个实现文章中,有一个更好看的图:

该图的输入是一张28*28大小的图像,在C1层有6个5*5的卷积核,因为C1层输出6个(28-5+1)(28-5+1)大小的feature map。然后经过子采样层,这里假设子采样层是对卷积层的均值处理(mean pooling), 其实一般还会有加偏置和激活的操作,为了简化,省略了这两步,只是对卷积层进行一个采样的操作。因此S2层输出的6个feature map大小为(24/2)(24/2).在卷积层C3中,它的输入是6个feature map,与C1不一样(C1只有一个feature map,如果是RGB的话,C1会有三个channel)。C3层有12个5*5卷积核,每个卷积核会与上一层的6个feature map分别做卷积(事实上,一般是选择几种输入feature map来做卷积,而不是全部的feature map),然后对这6个卷积结果求和组成一个新的feature map,即该层会有12个大小为(12-5+1)*(12-5+1)的feature map,这个feature map是经过sigmod 函数处理然后结果下一层S4。

同理,S4层有12个(与卷积层的feature map数一致)大小为(8/2)*(8/2)的feature map。输出层把S4层的feature mapflatten一个向量,向量长度为12*4*4=192,以该向量作为输入,与下面的其它层全连接,进行分类等操作,也就是说把一张图片变成一个向量,接入到别的网络,如传统的BP神经网络,不过从整体来看,CNN可以看做是一个BP神经网络。

(李宏毅的深度学习课上cnn那节有讲,互相补充)

最新文章

- Elasticsearch集群状态脚本及grafana监控面板导出的json文件

- CAR

- leetcode: Path Sum II 迭代法

- Reflection实现通用增删改

- java泛型问题 关于警告:XX is a raw type

- Advanced Customization of the jQuery Mobile Buttons | Appcropolis

- wamp在win7下64位系统memcache/memcached安装教程

- css学习之 display:inline-block;

- js获取前之前或之后的日期

- php中$_FILES应用实例

- Java面试官最常问的volatile关键字

- hibernate 5.2.12配置

- Linux上使用源代码安装软件

- 在Java路上,我看过的一些书、源码和框架(转)

- 涨姿势:深入 foreach循环

- Windows下安装Tensorflow(python3.6):记录过程

- 【代码片段】如何使用CSS来快速定义多彩光标

- Mybatis之使用注解开发CRUD

- sencha touch list 批量选择扩展(2013-7-29)

- C# 后台动态添加标签(span,div) 以及模板添加