深度学习基础(十二)—— ReLU vs PReLU

2024-08-31 18:35:49

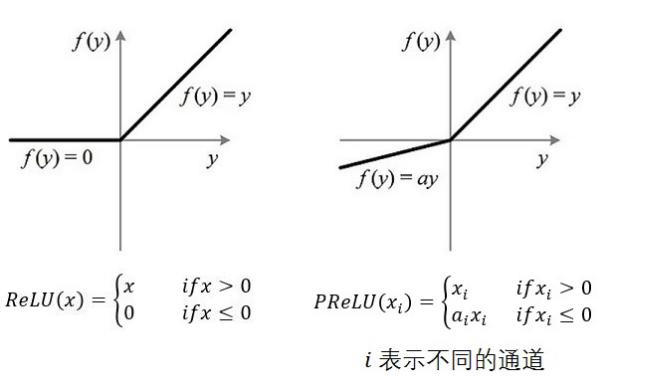

从算法的命名上来说,PReLU 是对 ReLU 的进一步限制,事实上 PReLU(Parametric Rectified Linear Unit),也即 PReLU 是增加了参数修正的 ReLU。

在功能范畴上,ReLU 、 PReLU 和 sigmoid 、 tanh 函数一样都是作为神经元的激励函数(activation function)。

1. ReLU 与 PReLU

注意图中通道的概念,不通的通道对应不同的 $$

如果 ai=0,那么 PReLU 退化为 ReLU;如果 ai 是一个很小的固定值(如ai=0.01),则 PReLU 退化为 Leaky ReLU(LReLU)。 有实验证明,与 ReLU 相比,LReLU 对最终的结果几乎没什么影响。

2. 说明

PReLU 只增加了极少量的参数,也就意味着网络的计算量以及过拟合的危险性都只增加了一点点。特别的,当不同 channels 使用相同的 ai 时,参数就更少了。

BP 更新 ai 时,采用的是带动量的更新方式,如下图:

Δai:=μΔai+ϵ∂ε∂ai上式的两个系数分别是动量和学习率。

需要特别注意的是:更新 ai 时不施加权重衰减(L2正则化),因为这会把 ai 很大程度上 push 到 0。事实上,即使不加正则化,试验中 ai 也很少有超过1的。

整个论文,ai 被初始化为 0.25。

3. references

《Delving Deep into Rectifiers:Surpassing Human-Level Performance on ImageNet Classification》

最新文章

- Windows10上安装EDEM2.7

- 【Python数据分析】Python3操作Excel-以豆瓣图书Top250为例

- 作业3(PSP表格)

- MVC编写的新闻页面

- POJ 3071 Football

- Linux磁盘操作命令

- 2013/11/21工作随笔-PHP开启多进程

- SQL 统计表行数和空间大小

- TCP拥塞控制算法内核实现剖析(十)

- 关于本地化(localization)

- Leetcode_263_Ugly Number

- 115、如何构建Android MVVM 应用框架(转载)

- kaili 安装中文输入法

- 利用dwebsocket在Django中使用Websocket

- E - TOYS

- hdu3746 Cyclic Nacklace【nxt数组应用】【最小循环节】

- macOS搭建开发环境

- .2-浅析express源码之applicaiton模块(1)-咸鱼方法

- Flow中的Switch分析

- 网页尺寸offsetHeight,offsetWidth