HashMap 的深入学习

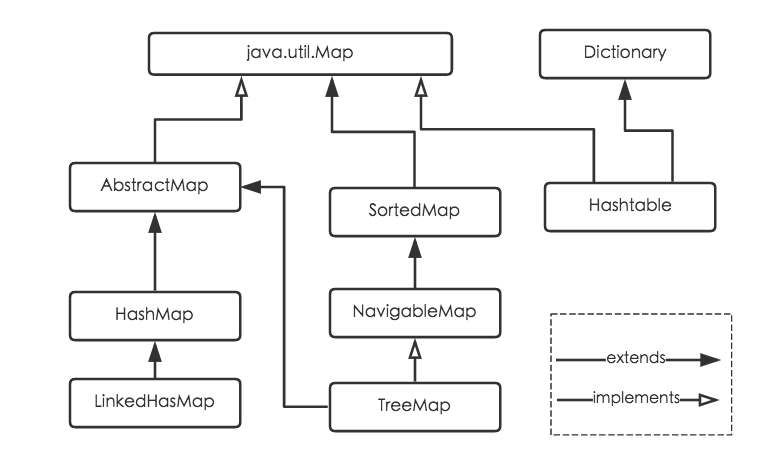

Java为数据结构中的映射定义了一个接口java.util.Map,此接口主要有四个常用的实现类,分别是HashMap、Hashtable、LinkedHashMap和TreeMap,类继承关系如下图所示:

下面针对各个实现类的特点做一些说明:

(1) HashMap:它根据键的hashCode值存储数据,大多数情况下可以直接定位到它的值,因而具有很快的访问速度,但遍历顺序却是不确定的。 HashMap最多只允许一条记录的键为null,允许多条记录的值为null。HashMap非线程安全,即任一时刻可以有多个线程同时写HashMap,可能会导致数据的不一致。如果需要满足线程安全,可以用 Collections的synchronizedMap方法使HashMap具有线程安全的能力,或者使用ConcurrentHashMap。

(2) Hashtable:Hashtable是遗留类,很多映射的常用功能与HashMap类似,不同的是它承自Dictionary类,并且是线程安全的,任一时间只有一个线程能写Hashtable,并发性不如ConcurrentHashMap,因为ConcurrentHashMap引入了分段锁。Hashtable不建议在新代码中使用,不需要线程安全的场合可以用HashMap替换,需要线程安全的场合可以用ConcurrentHashMap替换。

(3) LinkedHashMap:LinkedHashMap是HashMap的一个子类,保存了记录的插入顺序,在用Iterator遍历LinkedHashMap时,先得到的记录肯定是先插入的,也可以在构造时带参数,按照访问次序排序。

(4) TreeMap:TreeMap实现SortedMap接口,能够把它保存的记录根据键排序,默认是按键值的升序排序,也可以指定排序的比较器,当用Iterator遍历TreeMap时,得到的记录是排过序的。如果使用排序的映射,建议使用TreeMap。在使用TreeMap时,key必须实现Comparable接口或者在构造TreeMap传入自定义的Comparator,否则会在运行时抛出java.lang.ClassCastException类型的异常。

对于上述四种Map类型的类,要求映射中的key是不可变对象。不可变对象是该对象在创建后它的哈希值不会被改变。如果对象的哈希值发生变化,Map对象很可能就定位不到映射的位置了。

通过上面的比较,我们知道了HashMap是Java的Map家族中一个普通成员,鉴于它可以满足大多数场景的使用条件,所以是使用频度最高的一个。下文我们主要结合源码,从存储结构、常用方法分析、扩容以及安全性等方面深入讲解HashMap的工作原理。

public class HashMap<K,V> extends AbstractMap<K,V>

HashMap 根据键的 hashCode 值存储数据,大多数情况下可以直接定位到它的值,因而具有很快的访问速度,但遍历顺序却是不确定的。 HashMap 最多只允许一条记录的键为 null ,允许多条记录的值为 null 。HashMap 非线程安全,即任一时刻可以有多个线程同时写 HashMap,可能会导致数据的不一致。如果需要满足线程安全,可以用 Collections的synchronizedMap 方法使 HashMap 具有线程安全的能力,或者使用ConcurrentHashMap 。

一、HashMap 存储结构

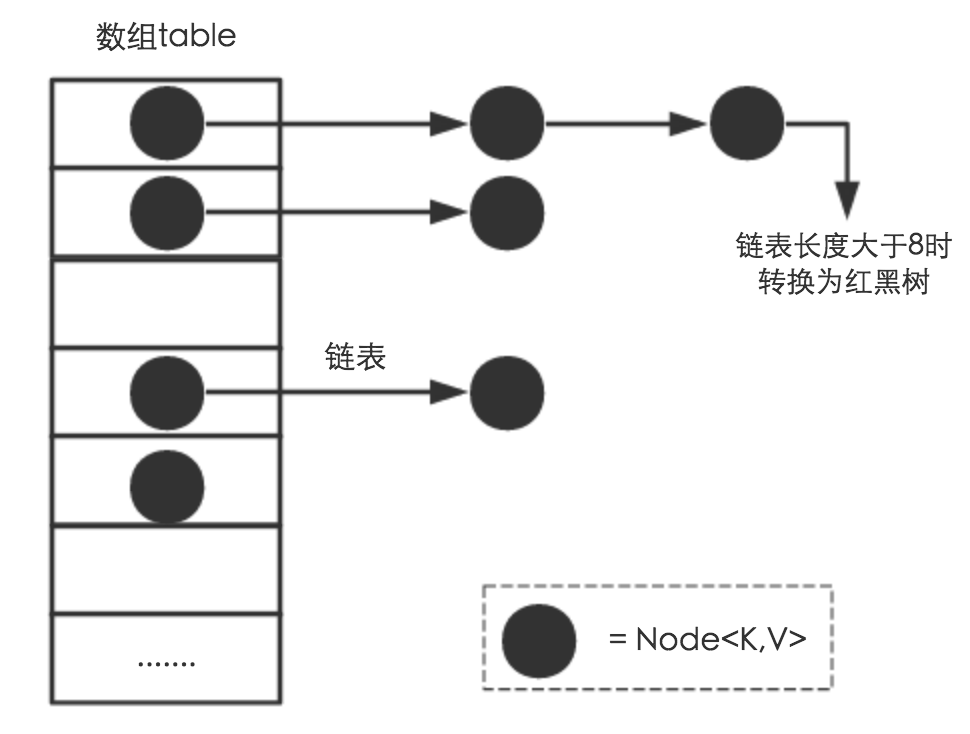

HashMap是数组+链表+红黑树(JDK1.8增加了红黑树部分)实现的,如下图所示:

数组存储区间是连续的,占用内存严重,故空间复杂的很大。但数组的二分查找时间复杂度小,为O(1);数组的特点是:寻址容易,插入和删除困难;

链表

链表存储区间离散,占用内存比较宽松,故空间复杂度很小,但时间复杂度很大,达O(N)。链表的特点是:寻址困难,插入和删除容易。

那么我们结合数组与链表的特性,做出一种寻址容易,插入删除也容易的数据结构,这就是我们要提起的哈希表。哈希表((Hash table)既满足了数据的查找方便,同时不占用太多的内容空间,使用也十分方便。

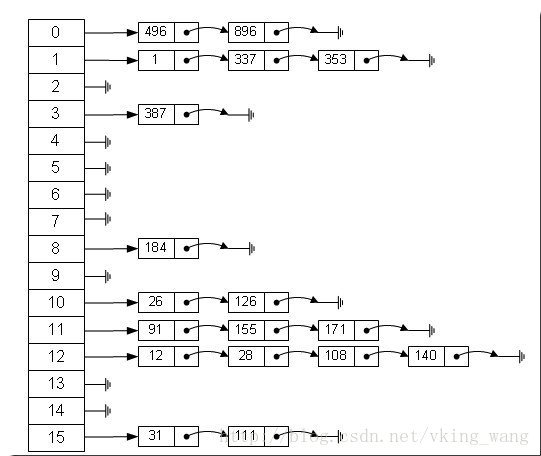

哈希表有多种不同的实现方法,我接下来解释的是最常用的一种方法—— 拉链法,我们可以理解为“链表的数组” ,如图:

从上图我们可以发现哈希表是由数组+链表组成的,一个长度为16的数组中,每个元素存储的是一个链表的头结点。那么这些元素是按照什么样的规则存储到数组中呢。一般情况是通过hash(key)%len获得,也就是元素的key的哈希值对数组长度取模得到。比如上述哈希表中,12%16=12,28%16=12,108%16=12,140%16=12。所以12、28、108以及140都存储在数组下标为12的位置

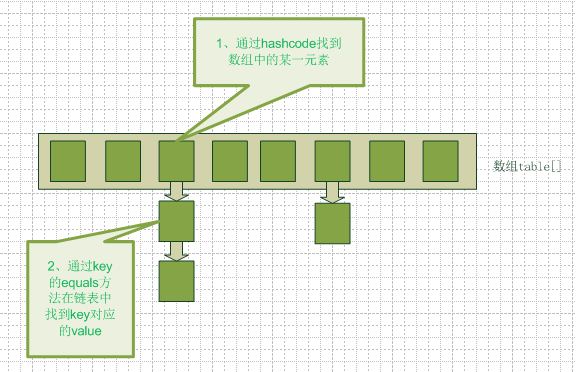

从上图中可以看出,HashMap底层就是一个数组结构,数组中的每一项又是一个链表。当新建一个HashMap的时候,就会初始化一个数组。

/// Node<K,V> 类用来实现数组及链表的数据结构

static class Node<K,V> implements Map.Entry<K,V> {

final int hash; //保存节点的 hash 值

final K key; //保存节点的 key 值

V value; //保存节点的 value 值

Node<K,V> next; //指向链表结构下的当前节点的 next 节点,红黑树 TreeNode 节点中也有用到 Node(int hash, K key, V value, Node<K,V> next) {

this.hash = hash;

this.key = key;

this.value = value;

this.next = next;

} public final K getKey() { return key; }

public final V getValue() { return value; }

public final String toString() { return key + "=" + value; } public final int hashCode() {

return Objects.hashCode(key) ^ Objects.hashCode(value);

} public final V setValue(V newValue) {

V oldValue = value;

value = newValue;

return oldValue;

} public final boolean equals(Object o) {

if (o == this)

return true;

if (o instanceof Map.Entry) {

Map.Entry<?,?> e = (Map.Entry<?,?>)o;

if (Objects.equals(key, e.getKey()) &&

Objects.equals(value, e.getValue()))

return true;

}

return false;

}

}

public class LinkedHashMap<K,V> {

static class Entry<K,V> extends HashMap.Node<K,V> {

Entry<K,V> before, after;

Entry(int hash, K key, V value, Node<K,V> next) {

super(hash, key, value, next);

}

}

}

// TreeNode<K,V> 继承 LinkedHashMap.Entry<K,V>,用来实现红黑树相关的存储结构

// hashMap中的类

static final class TreeNode<K,V> extends LinkedHashMap.Entry<K,V> {

TreeNode<K,V> parent; // 存储当前节点的父节点

TreeNode<K,V> left; //存储当前节点的左孩子

TreeNode<K,V> right; //存储当前节点的右孩子

TreeNode<K,V> prev; // 存储当前节点的前一个节点

boolean red; // 存储当前节点的颜色(红、黑)

TreeNode(int hash, K key, V val, Node<K,V> next) {

super(hash, key, val, next);

}

/**

* Returns root of tree containing this node.

*/

final TreeNode<K,V> root() {

}

/**

* Ensures that the given root is the first node of its bin.

*/

static <K,V> void moveRootToFront(Node<K,V>[] tab, TreeNode<K,V> root) {

} final TreeNode<K,V> find(int h, Object k, Class<?> kc) {

} final void treeify(Node<K,V>[] tab) {

} final Node<K,V> untreeify(HashMap<K,V> map) {

} final TreeNode<K,V> putTreeVal(HashMap<K,V> map, Node<K,V>[] tab,

int h, K k, V v) {

} final void removeTreeNode(HashMap<K,V> map, Node<K,V>[] tab,

boolean movable) {

} final void split(HashMap<K,V> map, Node<K,V>[] tab, int index, int bit) {

} /* ------------------------------------------------------------ */

// Red-black tree methods, all adapted from CLR

// 红黑树相关操作

static <K,V> TreeNode<K,V> rotateLeft(TreeNode<K,V> root,

TreeNode<K,V> p) {

} static <K,V> TreeNode<K,V> rotateRight(TreeNode<K,V> root,

TreeNode<K,V> p) {

} static <K,V> TreeNode<K,V> balanceInsertion(TreeNode<K,V> root,

TreeNode<K,V> x) {

} static <K,V> TreeNode<K,V> balanceDeletion(TreeNode<K,V> root,

TreeNode<K,V> x) {

} static <K,V> boolean checkInvariants(TreeNode<K,V> t) {

} }

HashMap 各常量、成员变量作用

创建 HashMap 时未指定初始容量情况下的默认容量

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4;

HashMap 的最大容量

static final int MAXIMUM_CAPACITY = 1 << 30;

HashMap 默认的装载因子,当 HashMap 中元素数量超过 容量*装载因子 时,进行 resize() 操作

static final float DEFAULT_LOAD_FACTOR = 0.75f;

用来确定何时将解决 hash 冲突的链表转变为红黑树

static final int TREEIFY_THRESHOLD = 8;

用来确定何时将解决 hash 冲突的红黑树转变为链表

static final int UNTREEIFY_THRESHOLD = 6;

当需要将解决 hash 冲突的链表转变为红黑树时,需要判断下此时数组容量,若是由于数组容量太小(小于 MIN_TREEIFY_CAPACITY )导致的 hash 冲突太多,则不进行链表转变为红黑树操作,转为利用 resize() 函数对 hashMap 扩容

static final int MIN_TREEIFY_CAPACITY = 64;

保存Node<K,V>节点的数组

transient Node<K,V>[] table;

由 hashMap 中 Node<K,V> 节点构成的 set

transient Set<Map.Entry<K,V>> entrySet;

记录 hashMap 当前存储的元素的数量

transient int size;

记录 hashMap 发生结构性变化的次数(注意 value 的覆盖不属于结构性变化)

transient int modCount;

threshold的值应等于 table.length * loadFactor, size 超过这个值时进行 resize()扩容

int threshold;

记录 hashMap 装载因子

final float loadFactor;

hashMap的构造函数

//构造方法1,指定初始容量及装载因子

public HashMap(int initialCapacity, float loadFactor) {

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal initial capacity: " +

initialCapacity);

if (initialCapacity > MAXIMUM_CAPACITY)

initialCapacity = MAXIMUM_CAPACITY;

if (loadFactor <= 0 || Float.isNaN(loadFactor))

throw new IllegalArgumentException("Illegal load factor: " +

loadFactor);

this.loadFactor = loadFactor;

/* tableSizeFor(initialCapacity) 方法返回的值是最接近 initialCapacity 的2的幂,若指定初始容量为9,则实际 hashMap

容量为16*/

//注意此种方法创建的 hashMap 初始容量的值存在 threshold 中

this.threshold = tableSizeFor(initialCapacity);

}

//tableSizeFor(initialCapacity) 方法返回的值是最接近 initialCapacity 的2的幂

static final int tableSizeFor(int cap) {

int n = cap - 1;

n |= n >>> 1;// >>> 代表无符号右移

n |= n >>> 2;

n |= n >>> 4;

n |= n >>> 8;

n |= n >>> 16;

return (n < 0) ? 1 : (n >= MAXIMUM_CAPACITY) ? MAXIMUM_CAPACITY : n + 1;

}

//构造方法2,仅指定初始容量,装载因子的值采用默认的 0.75

public HashMap(int initialCapacity) {

this(initialCapacity, DEFAULT_LOAD_FACTOR);

}

//构造方法3,所有参数均采用默认值

public HashMap() {

this.loadFactor = DEFAULT_LOAD_FACTOR; // all other fields defaulted

}

hashMap的put及相关方法

分析HashMap的put方法

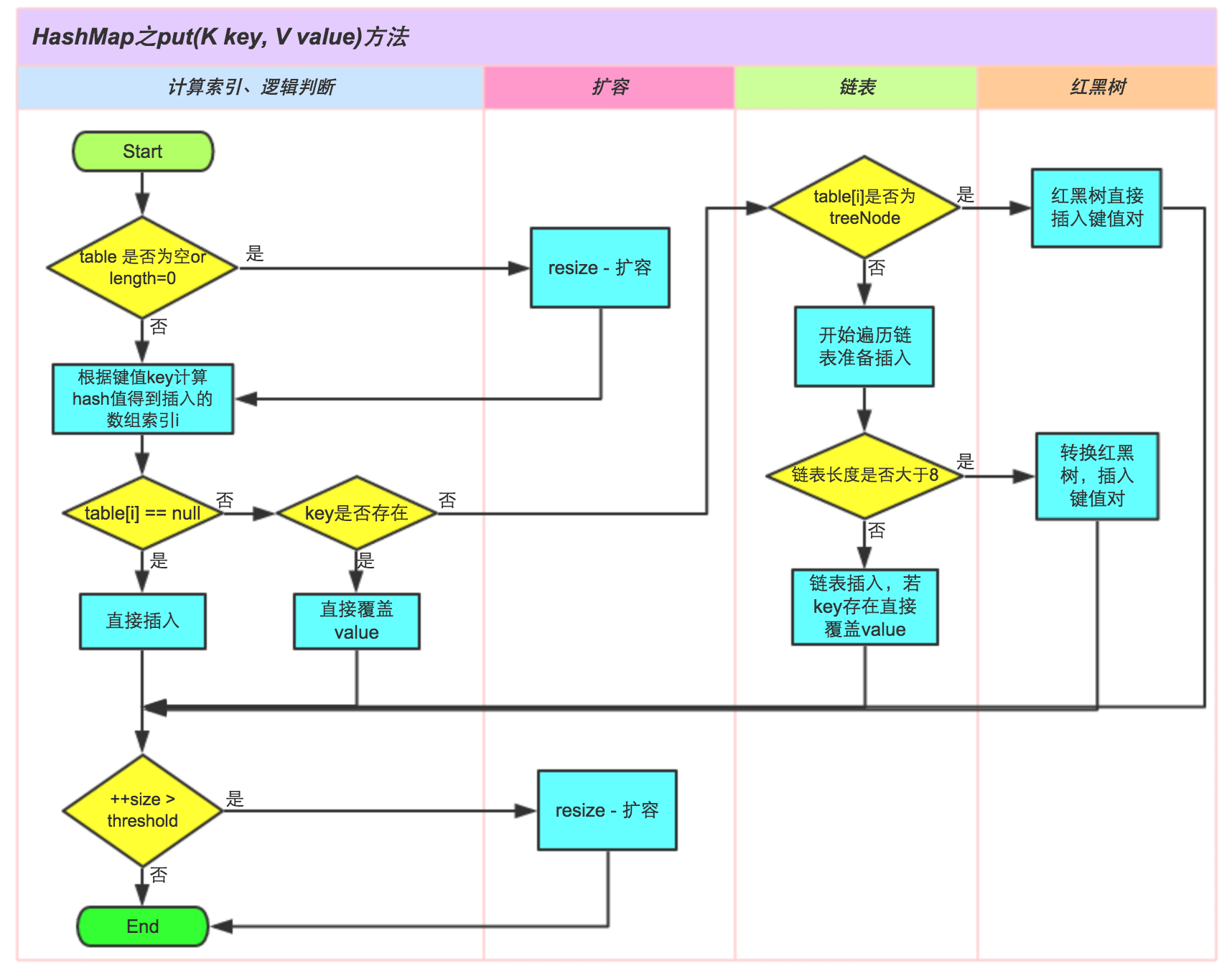

HashMap的put方法执行过程可以通过下图来理解,

①.判断键值对数组table[i]是否为空或为null,否则执行resize()进行扩容;

②.根据键值key计算hash值得到插入的数组索引i,如果table[i]==null,直接新建节点添加,转向⑥,如果table[i]不为空,转向③;

③.判断table[i]的首个元素是否和key一样,如果相同直接覆盖value,否则转向④,这里的相同指的是hashCode以及equals;

④.判断table[i] 是否为treeNode,即table[i] 是否是红黑树,如果是红黑树,则直接在树中插入键值对,否则转向⑤;

⑤.遍历table[i],判断链表长度是否大于8,大于8的话把链表转换为红黑树,在红黑树中执行插入操作,否则进行链表的插入操作;遍历过程中若发现key已经存在直接覆盖value即可;

⑥.插入成功后,判断实际存在的键值对数量size是否超多了最大容量threshold,如果超过,进行扩容。

public V put(K key, V value) {

// 对key的hashCode()做hash

return putVal(hash(key), key, value, false, true);

}

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node<K,V>[] tab; Node<K,V> p; int n, i;

// 步骤①:tab为空则创建

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

// 步骤②:计算index,并对null做处理

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);

else {

Node<K,V> e; K k;

// 步骤③:节点key存在,直接覆盖value

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

// 步骤④:判断该链为红黑树

else if (p instanceof TreeNode)

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

// 步骤⑤:该链为链表

else {

for (int binCount = 0; ; ++binCount) {

if ((e = p.next) == null) {

p.next = newNode(hash, key,value,null);

//链表长度大于8转换为红黑树进行处理

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

// key已经存在直接覆盖value

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

// 步骤⑥:超过最大容量 就扩容

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

/*读懂这个函数要注意理解 hash 冲突发生的几种情况

1、两节点 key 值相同(hash值一定相同),导致冲突

2、两节点 key 值不同,由于 hash 函数的局限性导致hash 值相同,冲突

3、两节点 key 值不同,hash 值不同,但 hash 值对数组长度取模后相同,冲突

*/

final TreeNode<K,V> putTreeVal(HashMap<K,V> map, Node<K,V>[] tab,

int h, K k, V v) {

Class<?> kc = null;

boolean searched = false;

TreeNode<K,V> root = (parent != null) ? root() : this;

//从根节点开始查找合适的插入位置(与二叉搜索树查找过程相同)

for (TreeNode<K,V> p = root;;) {

int dir, ph; K pk;

if ((ph = p.hash) > h)

dir = -1; // dir小于0,接下来查找当前节点左孩子

else if (ph < h)

dir = 1; // dir大于0,接下来查找当前节点右孩子

else if ((pk = p.key) == k || (pk != null && k.equals(pk)))

//进入这个else if 代表 hash 值相同,key 相同

return p;

/*要进入下面这个else if,代表有以下几个含义:

1、当前节点与待插入节点 key 不同, hash 值相同

2、k是不可比较的,即k并未实现 comparable<K> 接口

(若 k 实现了comparable<K> 接口,comparableClassFor(k)返回的是k的 class,而不是 null)

或者 compareComparables(kc, k, pk) 返回值为 0

(pk 为空 或者 按照 k.compareTo(pk) 返回值为0,

返回值为0可能是由于 k的compareTo 方法实现不当引起的,compareTo 判定相等,而上个 else if 中 equals

判定不等)*/

else if ((kc == null &&

(kc = comparableClassFor(k)) == null) ||

(dir = compareComparables(kc, k, pk)) == 0) {

//在以当前节点为根的整个树上搜索是否存在待插入节点(只会搜索一次)

if (!searched) {

TreeNode<K,V> q, ch;

searched = true;

if (((ch = p.left) != null &&

(q = ch.find(h, k, kc)) != null) ||

((ch = p.right) != null &&

(q = ch.find(h, k, kc)) != null))

//若树中存在待插入节点,直接返回

return q;

}

// 既然k是不可比较的,那我自己指定一个比较方式

dir = tieBreakOrder(k, pk);

}//end else if TreeNode<K,V> xp = p;

if ((p = (dir <= 0) ? p.left : p.right) == null) {

//找到了待插入的位置,xp 为待插入节点的父节点

//注意TreeNode节点中既存在树状关系,也存在链式关系,并且是双端链表

Node<K,V> xpn = xp.next;

TreeNode<K,V> x = map.newTreeNode(h, k, v, xpn);

if (dir <= 0)

xp.left = x;

else

xp.right = x;

xp.next = x;

x.parent = x.prev = xp;

if (xpn != null)

((TreeNode<K,V>)xpn).prev = x;

//插入节点后进行二叉树的平衡操作

moveRootToFront(tab, balanceInsertion(root, x));

return null;

}

}//end for

}//end putTreeVal

static int tieBreakOrder(Object a, Object b) {

int d;

//System.identityHashCode()实际是利用对象 a,b 的内存地址进行比较

if (a == null || b == null ||

(d = a.getClass().getName().

compareTo(b.getClass().getName())) == 0)

d = (System.identityHashCode(a) <= System.identityHashCode(b) ?

-1 : 1);

return d;

}

HashMap get 及其相关方法

public V get(Object key) {

Node<K,V> e;

//实际上是根据输入节点的 hash 值和 key 值利用getNode 方法进行查找

return (e = getNode(hash(key), key)) == null ? null : e.value;

}

final Node<K,V> getNode(int hash, Object key) {

Node<K,V>[] tab; Node<K,V> first, e; int n; K k;

if ((tab = table) != null && (n = tab.length) > 0 &&

(first = tab[(n - 1) & hash]) != null) {

if (first.hash == hash && // always check first node

((k = first.key) == key || (key != null && key.equals(k))))

return first;

if ((e = first.next) != null) {

if (first instanceof TreeNode)

//若定位到的节点是 TreeNode 节点,则在树中进行查找

return ((TreeNode<K,V>)first).getTreeNode(hash, key);

do {//否则在链表中进行查找

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

} while ((e = e.next) != null);

}

}

return null;

}

final TreeNode<K,V> getTreeNode(int h, Object k) {

//从根节点开始,调用 find 方法进行查找

return ((parent != null) ? root() : this).find(h, k, null);

}

final TreeNode<K,V> find(int h, Object k, Class<?> kc) {

TreeNode<K,V> p = this;

do {

int ph, dir; K pk;

TreeNode<K,V> pl = p.left, pr = p.right, q;

//首先进行hash 值的比较,若不同令当前节点变为它的左孩子或者右孩子

if ((ph = p.hash) > h)

p = pl;

else if (ph < h)

p = pr;

//hash 值相同,进行 key 值的比较

else if ((pk = p.key) == k || (k != null && k.equals(pk)))

return p;

else if (pl == null)

p = pr;

else if (pr == null)

p = pl;

//执行到这儿,意味着hash 值相同,key 值不同

//若k 是可比较的并且k.compareTo(pk) 返回结果不为0可进入下面elseif

else if ((kc != null ||

(kc = comparableClassFor(k)) != null) &&

(dir = compareComparables(kc, k, pk)) != 0)

p = (dir < 0) ? pl : pr;

/*若 k 是不可比较的 或者 k.compareTo(pk) 返回结果为0则在整棵树中进行查找,先找右子树,右子树没有再找左子树*/

else if ((q = pr.find(h, k, kc)) != null)

return q;

else

p = pl;

} while (p != null);

return null;

}

HashMap 扩容方法 resize()

扩容(resize)就是重新计算容量,向HashMap对象里不停的添加元素,而HashMap对象内部的数组无法装载更多的元素时,对象就需要扩大数组的长度,以便能装入更多的元素。当然Java里的数组是无法自动扩容的,方法是使用一个新的数组代替已有的容量小的数组,就像我们用一个小桶装水,如果想装更多的水,就得换大水桶。

我们分析下resize的源码,鉴于JDK1.8融入了红黑树,较复杂,为了便于理解我们仍然使用JDK1.7的代码,好理解一些,本质上区别不大,具体区别后文再说。

void resize(int newCapacity) { //传入新的容量

Entry[] oldTable = table; //引用扩容前的Entry数组

int oldCapacity = oldTable.length;

if (oldCapacity == MAXIMUM_CAPACITY) { //扩容前的数组大小如果已经达到最大(2^30)了

threshold = Integer.MAX_VALUE; //修改阈值为int的最大值(2^31-1),这样以后就不会扩容了

return;

}

Entry[] newTable = new Entry[newCapacity]; //初始化一个新的Entry数组

transfer(newTable); //!!将数据转移到新的Entry数组里

table = newTable; //HashMap的table属性引用新的Entry数组

threshold = (int)(newCapacity * loadFactor);//修改阈值

}

这里就是使用一个容量更大的数组来代替已有的容量小的数组,transfer()方法将原有Entry数组的元素拷贝到新的Entry数组里。

void transfer(Entry[] newTable) {

Entry[] src = table; //src引用了旧的Entry数组

int newCapacity = newTable.length;

for (int j = 0; j < src.length; j++) { //遍历旧的Entry数组

Entry<K,V> e = src[j]; //取得旧Entry数组的每个元素

if (e != null) {

src[j] = null;//释放旧Entry数组的对象引用(for循环后,旧的Entry数组不再引用任何对象)

do {

Entry<K,V> next = e.next;

int i = indexFor(e.hash, newCapacity); //!!重新计算每个元素在数组中的位置

e.next = newTable[i]; //标记[1]

newTable[i] = e; //将元素放在数组上

e = next; //访问下一个Entry链上的元素

} while (e != null);

}

}

}

newTable[i]的引用赋给了e.next,也就是使用了单链表的头插入方式,同一位置上新元素总会被放在链表的头部位置;这样先放在一个索引上的元素终会被放到Entry链的尾部(如果发生了hash冲突的话),这一点和Jdk1.8有区别,下文详解。在旧数组中同一条Entry链上的元素,通过重新计算索引位置后,有可能被放到了新数组的不同位置上。

下面举个例子说明下扩容过程。假设了我们的hash算法就是简单的用key mod 一下表的大小(也就是数组的长度)。其中的哈希桶数组table的size=2, 所以key = 3、7、5,put顺序依次为 5、7、3。在mod 2以后都冲突在table[1]这里了。这里假设负载因子 loadFactor=1,即当键值对的实际大小size 大于 table的实际大小时进行扩容。接下来的三个步骤是哈希桶数组 resize成4,然后所有的Node重新rehash的过程。

resize() 方法中比较重要的是链表和红黑树的 rehash 操作,先来说下 rehash 的实现原理:

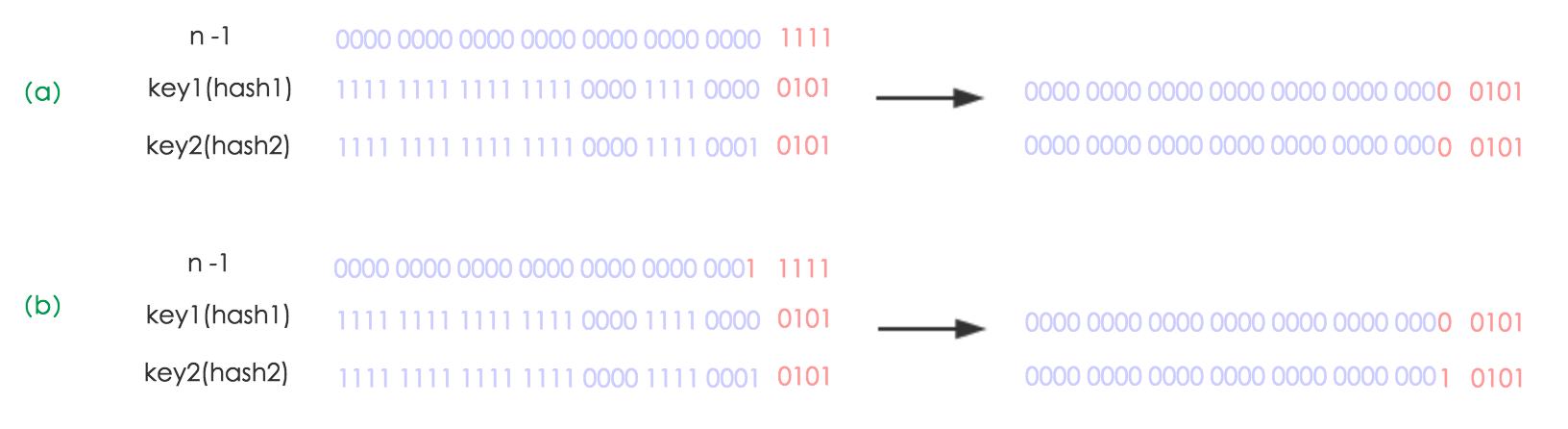

我们在扩容的时候,一般是把长度扩为原来2倍,所以,元素的位置要么是在原位置,要么是在原位置再移动2次幂的位置。看下图可以明白这句话的意思,n为table的长度,图(a)表示扩容前的key1和key2两种key确定索引位置的示例,图(b)表示扩容后key1和key2两种key确定索引位置的示例,其中hash1是key1对应的哈希与高位运算结果。

元素在重新计算hash之后,因为n变为2倍,那么n-1的mask范围在高位多1bit(红色),因此新的index就会发生这样的变化:

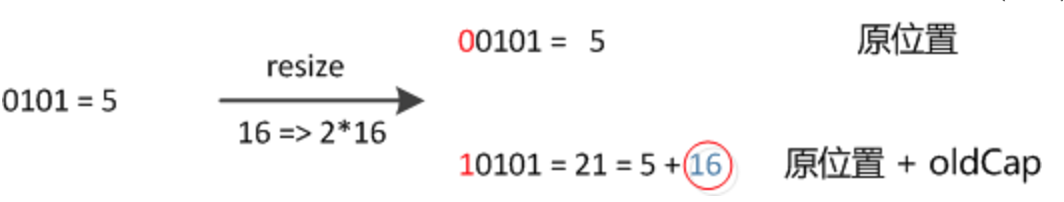

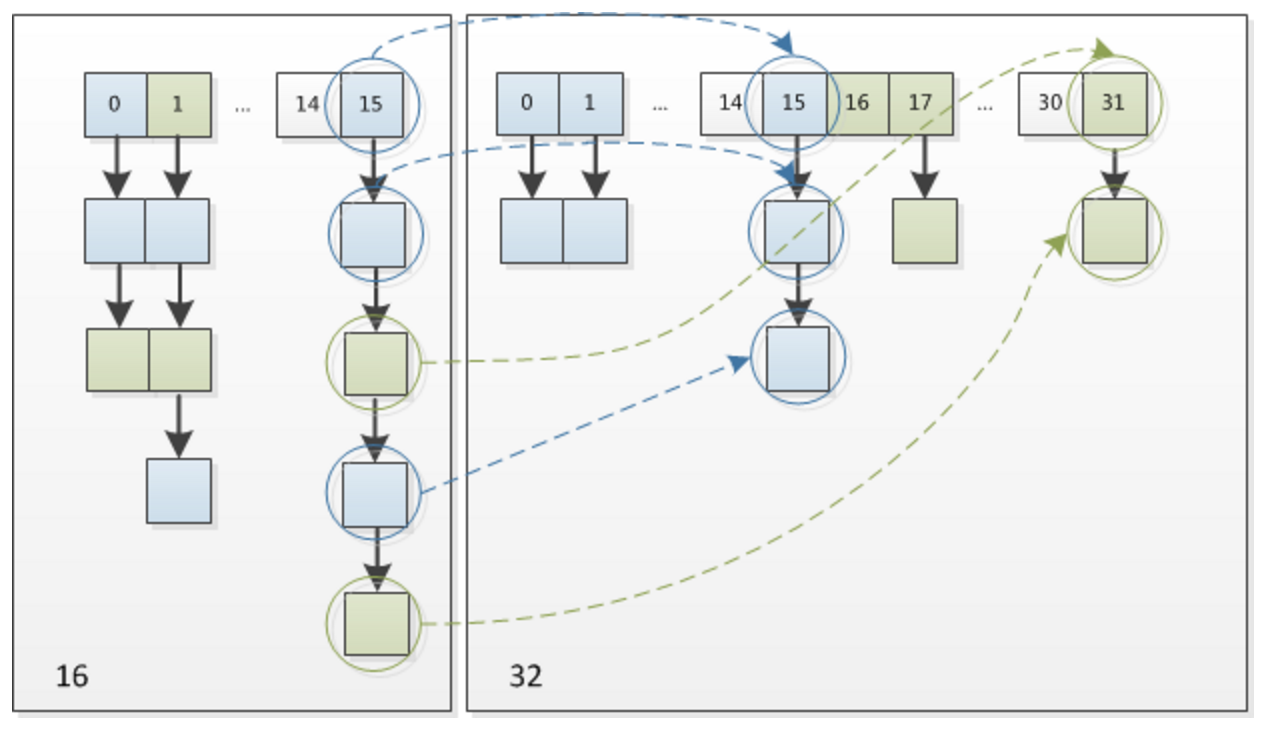

因此,我们在扩充HashMap的时候,只需要看看原来的hash值新增的那个bit是1还是0就好了,是0的话索引没变,是1的话索引变成“原索引+oldCap”,可以看看下图为16扩充为32的resize示意图:

这个算法很巧妙,既省去了重新计算hash值的时间,而且同时,由于新增的1bit是0还是1可以认为是随机的,因此resize的过程,均匀的把之前的冲突的节点分散到新的槽中了。

参考文章:http://tech.meituan.com/java-hashmap.html

最新文章

- UVA 101

- Java Selenium封装--RemoteWebElement

- JAVA_OPTS

- Ajax 密码验证

- linux下动态链接库解决方案(一)

- php的SAPI,CLI SAPI,CGI SAPI

- 学习心得:《十个利用矩阵乘法解决的经典题目》from Matrix67

- 0421 实验二Step2-FCFS调度

- cellspacing与cellpadding

- 远程管理之VNC

- python 函数应用

- 国内的一些开源镜像站汇总,EPEL源

- JS软键盘代码

- javascript动画效果之透明度

- Vue.js 系列教程 4:Vuex

- 前端基础之初识 HTML

- 经验总结22--抓取HTML数据,HtmlAgilityPack(续)

- iOS手机截屏使用

- eclipse中注释的代码依然会执行的解决方法

- ES6 new syntax of Default Function Parameters