Ensemble Learning

Ensemble Learning是机器学习里最常见的建模方法,RandomForest 和 GBDT 采用了Ensemble Learning模式,只是具体方法不同。

下面简单翻译下一 https://www.analyticsvidhya.com/blog/2015/09/questions-ensemble-modeling/ 这篇文章,再来理解一下Ensemble Learning模式。

与Ensemble Learning相关的常见问题

1、什么是Ensemble Learning?

2、什么是bagging, boosting, stacking?

3、同一个ML算法怎么做集成(ensemble)?

4、不同的模型如何确定权重?

5、ensemble模型有什么优势?

下面一个一个来回答。

1、什么是Ensemble Learning?

文中举了一个垃圾邮件检测的例子,简单来说就是,仅凭单个规则很难准确识别垃圾邮件,但是使用多条规则会提高识别的准确率。这个例子是为了说明,ensemble learning是一个“多合一”的方法。“多”指的是多个个体模型(individual models),注意,并非是多个独立模型;“合一”指的是多个模型共同形成一个识别/回归结果。Ensemble的一般特点是,多个模型间的相关性越低,合成之后的识别/回归效果越好。

具体的合成方法有多种,其中最典型的ensemble算法是随机森林(Random Forest)。引用文中的话是:

It (Random Forest)performs better compared to individual CART model by classifying a new object where each tree gives “votes” for that class and the forest chooses the classification having the most votes (over all the trees in the forest). In case of regression, it takes the average of outputs of different trees.

2、什么是bagging, boosting, stacking?

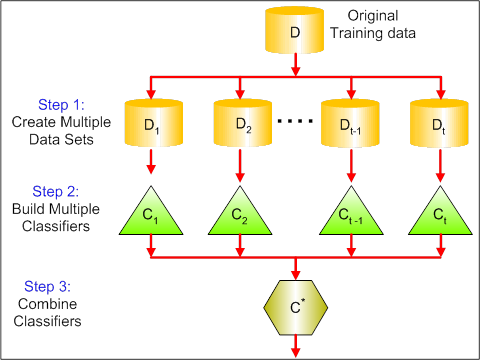

Bagging是对样本进行采样,构造出若干个新数据集,然后对应训练出若干个模型,再把这些模型合而为一,得到输出结果。其本质是降低了模型的方差(Variance)。

Boosting是一种模型迭代方法,初始化时,有一个简单的模型、各样本权重相等,由此得到识别结果,根据识别结果调整样本权重,判错的样本权重变大,据此得到新的模型,把新模型迭代到老模型上,再得到识别结果,如此循环迭代下去,最终若干个模型叠加在一起,得到最终的输出模型。

Boosting一般精确率比Bagging更高,但是容易过拟合(over-fit)。

常见的两种Boosting算法是 AdaBoost 和 Gradient Boosting。

[原文中的图没看懂,就不附图了]

Stacking就是简单的模型合成,先从原数据中训练得到若干个模型,然后用一个函数把若干个模型合成,输出最终的识别/回归结果。这里并没有介绍如何做合成,日后遇到具体案例再来细聊。

3、同一个ML算法怎么做集成(ensemble)?

可以把相同的模型集成起来,但是这样做的效果通常不会太好,更提倡的做法是把不同类型的模型集成起来,比如 把Random Forest , KNN 和 Naive Beyes集成起来,模型之间越是不同,集成后的效果往往越好。

文中举了个反直觉的例子,三个模型(A, B, C),识别的精确率分别是85%,80%和50%,A和B相关性很强,C和A, B的相关性很低,此时把A和B做集成是错误的,应该把A和C或者B和C做集成。

4、不同的模型如何确定权重?

不用动脑子的权重设置方法是等权重,动动脑子的方法有以下几个:

1. 计算多个base model的collinearity,基于得到的collinearity矩阵做model筛选,然后根据筛选出的model的cross validation score来确定model 的weight。 [这段话没有真正理解,需要实践来验证]

2. 利用单独的算法来确定权重,文中推荐了一篇文章 Finding Optimal Weights of Ensemble Learner using Neural Network 。

3. 可以借鉴其他算法,例如 Forward Selection of learners Selection with Replacement Bagging of ensemble methods 。

还可以到Kaggle上查找优秀的解决方案,学习那些方案中的ensemble方法。

5、ensemble模型有什么优势?

ensemble的优势在于两点:一是判别的精确率更高,二是模型更稳定,换一种说法是,ensemble可以减小偏差,减小方差,最终减小模型的泛化误差。

后记:ensemble learning方法本身不难理解,难在如何应用,待后续工作中有了应用案例再来写续篇。

最新文章

- Wpf/Wp/Silverlight-Chart图表控件:柱状图、饼状图等使用汇总

- Angular解决双向数据绑定

- 第二题 已知有十六支男子足球队参加2008 北京奥运会。写一个程序,把这16 支球队随机分为4 个组。采用List集合和随机数 2008 北京奥运会男足参赛国家: 科特迪瓦,阿根廷,澳大利亚,塞尔维亚,荷兰,尼日利亚、日本,美国,中国,新西 兰,巴西,比利时,韩国,喀麦隆,洪都拉斯,意大利

- java 25 - 4 网络编程之 UDP协议传输的代码优化

- 为什么 SharedPreferences 可以直接 调用,前面却没有对象

- Sources

- [Android Pro] RecyclerView实现瀑布流效果(二)

- AIX 第4章 指令记录

- 最全C语言笔记回顾

- Android padding和margin的区别

- js 时间戳转为日期格式

- 《Windows编程循序渐进》——基本控件

- C++string函数之strcat_s

- C#之Invoke学习

- es6 语法 (let 和const)

- [matlab] 12.Optimization Tool的使用

- swift kvc赋值

- BD是什么角色

- python动态函数名的研究

- 子窗口访问父页面iframe中的iframe,top打开的子窗口访问父页面中的iframe中的iframe

热门文章

- Android.mk文件c++头文件包含问题

- 基于jQuery的计算文本框字数的代码-jquery

- linux -- Ubuntu查看修改mysql的登录名和密码、安装phpmyadmin

- 安装配置好openstack环境的虚拟机,须要改动ip时,在数据库中同步改动ip的方法

- IPV6设置

- linux定时任务cron 安装配置

- mybatis由浅入深day01_6SqlMapConfig.xml(6.2settings全局参数配置_6.3typeAliases(类型别名)_6.4typeHandlers(类型处理器)_6.5mappers(映射配置))

- JBPM4.4_管理流程定义

- Java类的设计----方法的重写、覆盖

- 如何根据select选择的值反查option的属性