Real-time ‘Actor-Critic’ Tracking

Real-time ‘Actor-Critic’ Tracking

2019-07-15 10:49:16

Code: https://github.com/bychen515/ACT

1. Background and Motivation:

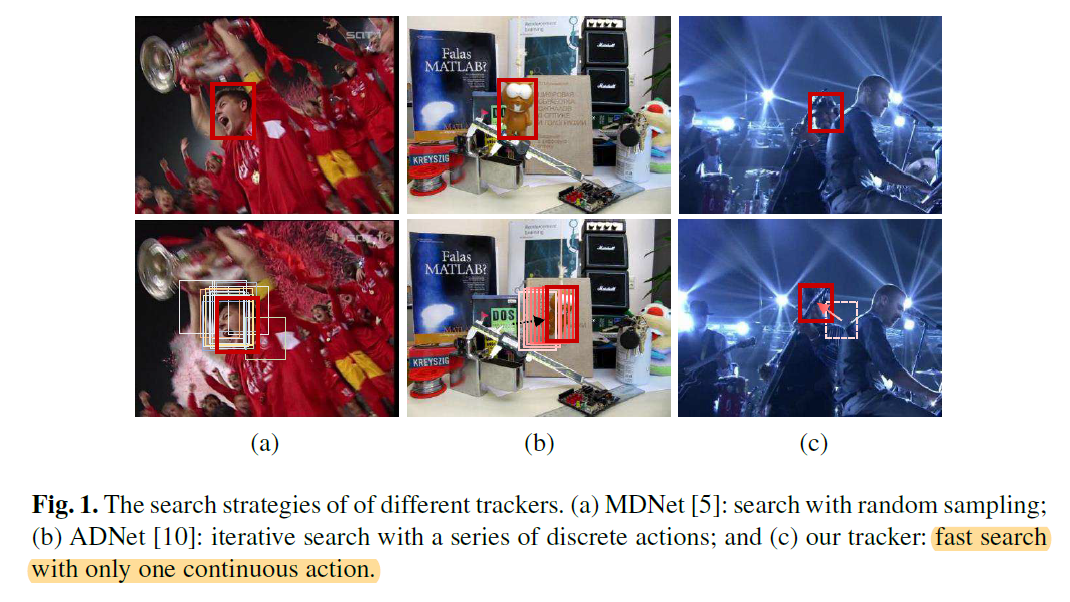

本文提出一种利用 “连续” 动作空间的强化学习算法来进行跟踪。之前的 MDNET 是随机采样,然后进行打分的;而 ADNet 是 “离散”的动作选择,即:通过一系列离散的动作选择,实现 BBox 的移动,来完成跟踪。下图展示了本文方法与这两种方法的不同:

本文的贡献点在于:

1). 该算法是首次探索了连续的动作 (continuous actions) 进行跟踪,仅通过 Actor model 进行一次动作选择,即可完成动作的定位;

2). 该算法也是首次利用 “Actor-Critic” 跟踪框架。

3). 在速度达到实时的同时,精度也比不错。

2. Tracking via the "Actor-Critic" Network:

2.1 Problem Settings:

本文将跟踪问题看做是序列决策问题(Decision-making problem)。基础的马尔科夫决策过程包括如下几个元素:State,Action,State transition functions,Reward。

在本文中,tracker 被当做是 agent,并且来预测每一帧目标物体的准确位置。该智能体与环境进行交互,通过观察 s,执行动作 a,并且得到奖励 r。在第 t 帧中,智能体根据当前的状态 s,给出了连续的动作 a,得到了跟踪结果 s'。动作 a 被定义为:the relative motion of the tracked object,表明在当前帧,应该怎么直接移动 BBOX。与 ADNET 不同的是,该算法仅仅执行一个连续的动作,来定位目标物体,使得该算法更加高效。具体各个元素的定义如下:

State:

在该工作中,作者定义状态 s 为:在BBox内部的观察到的图像块。给定视频帧 F 和 BBox b = [x, y, h, w],作者首先用预处理函数 s 来处理得到该图像块。

Action and State Transition:

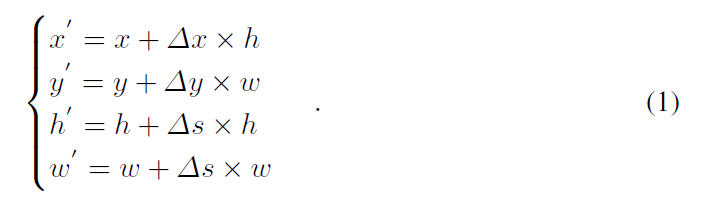

为了进行连续的控制,动作空间被假设为连续的,即:如何直接移动该 BBox。此处,作者用 $a = [\Delta x, \Delta y, \Delta s]$ 来描绘跟踪物体的相对运动,$\Delta x, \Delta y$ 表明了物体水平和竖直方向的变换,$\Delta s$ 表明了尺寸的相对变换。考虑到跟踪物体时序上的连续性,作者加了如下的约束来控制 BBox 的变化幅度:$-1 <= \Delta x <= 1, -1 <= \Delta y <= 1, -0.05 <= \Delta s <= 0.05$。通过对上一帧的 BBox 进行这样动作的变换,可以得到一个新的 BBox b' = [x' y' h' w']:

然后,状态转移过程 $s' = f(s, a)$ 可以隐式的通过预处理函数来实现。

Reward:

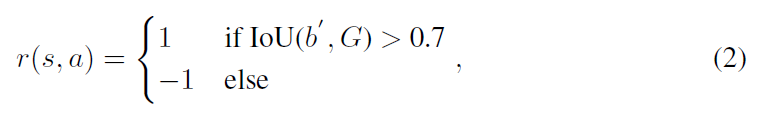

奖励函数 r(s, a) 描述了定位的准确性,所以,其可以按照重合度的方法进行度量:

每次执行一个 action,都会产生一个奖励,然后被用于离线训练的深度网络更新 (to update the deep networks in offline learning)。

2.2 Offline Training:

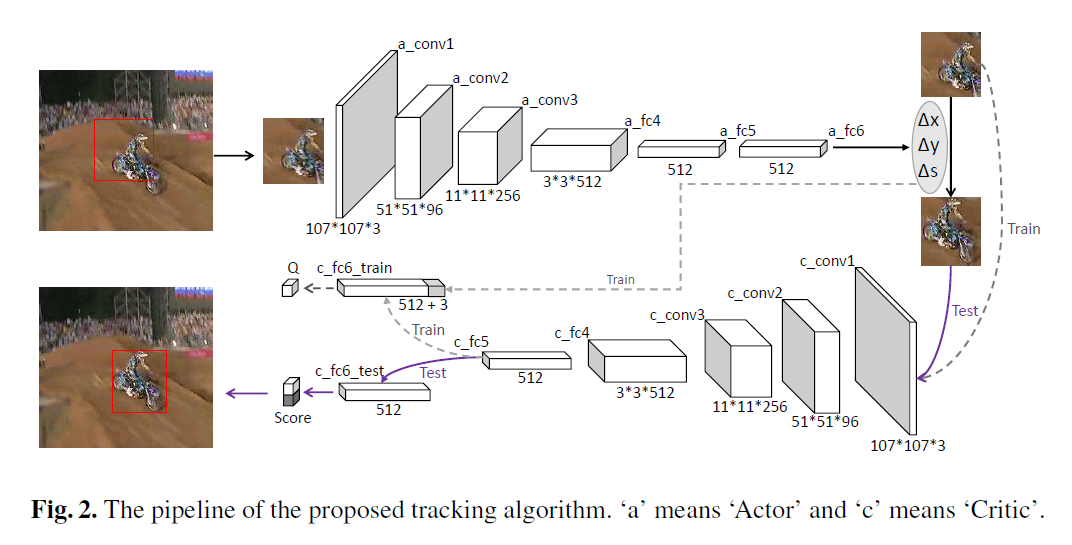

Network Architecture:

本文的网络结构如上图所示。可以看到 Actor network 是将上一帧的跟踪结果的 image patch 作为输入,输出是三维的数字,即对应了 水平,竖直 和 尺寸上的变换。在 offline training中,还有一个是 Critic network,该网络的结构跟 Actor 类似,但是用途是不同的。该网络要求的输入是:根据当前的状态,将三维 action vector 组合后的结果,以得到 Q-value,并用于动作的评价。

Training via DDPG:

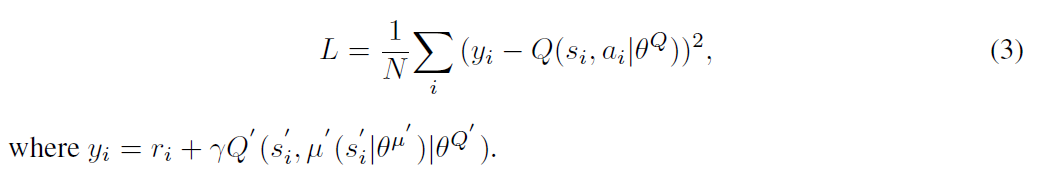

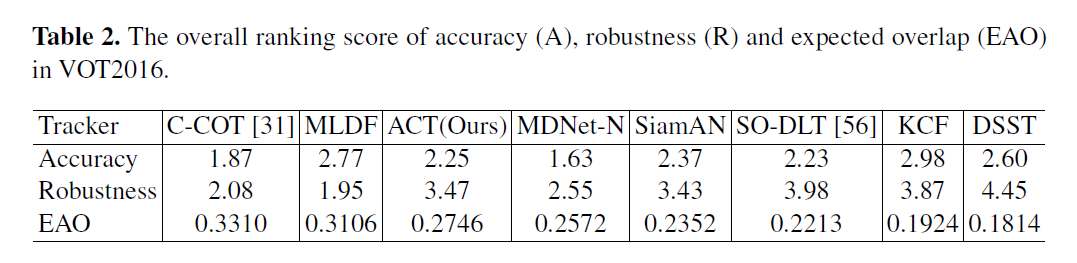

本文采用 DDPG 方法来训练该 “Actor-Critic Network”,核心的思想是:迭代的训练 “Critic” 和 “Actor” 模型。给定 N 个经验 (si, ai, ri, si'),Critic model 可以利用贝尔曼方程来进行学习。通过目标网络,学习可以通过最小化下面的损失来实现:

然后,Actor 模型可以通过链式法则进行更新:

在训练迭代中,作者随机的选择一个训练序列及其 GT。在此之后,作者将跟踪器在选择的序列上得到了训练 pair (st, at, rt, st') 。

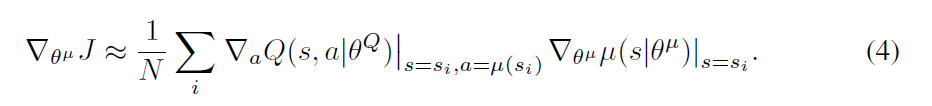

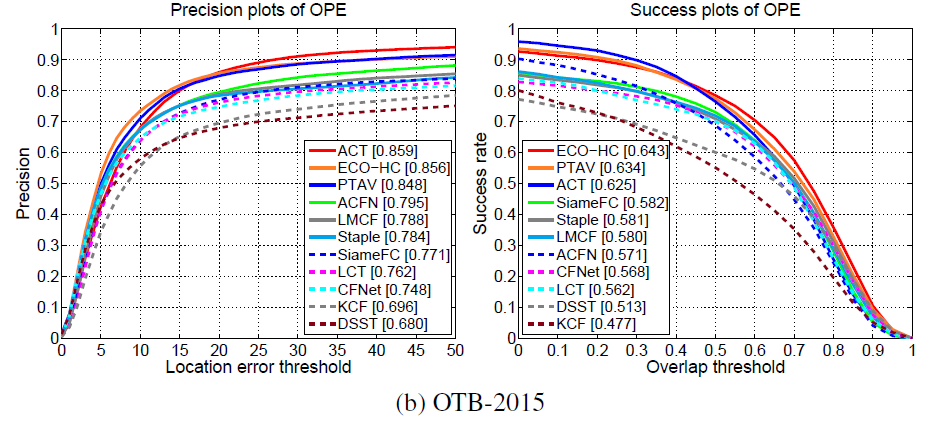

Experimental Results:

==

最新文章

- struts.xml的编辑

- 优秀开发人员网站推荐。——Arvin

- ASP.NETMVC自定义错误页面真的简单吗?

- linux中用户、组的管理(密码管理、权限管理及其修改用户、组)(转)

- CodeForces 37E Trial for Chief

- Spark Streaming实时计算框架介绍

- [2017.02.21] 《Haskell趣学指南 —— Learning You a Haskell for Great Good!》

- QGridLayout

- phpstorm连接服务器,实时编辑上传文件到服务器

- [03] 线程同步 synchronized

- Helm使用详解

- 单机安装ELK

- TYAttributedLabel——简单,强大的iOS属性文本控件

- C 预处理

- 密码强度demo(弱中强)

- springboot整合mybatis将sql打印到日志(转)

- 【专题】平衡树(Treap,fhq-treap)

- [OS] 生产者-消费者问题(有限缓冲问题)

- Windows平台下搭建Git服务器的图文教程

- python 截取指定长度汉字