Python机器学习/LinearRegression(线性回归模型)(附源码)

2024-08-24 08:22:51

LinearRegression(线性回归)

1.线性回归简介

线性回归定义:

我个人的理解就是:线性回归算法就是一个使用线性函数作为模型框架($y = w*x + b$)、并通过优化算法对训练数据进行训练、最终得出最优(全局最优解或局部最优)参数的过程。

y:我们需要预测的数值;

w:模型的参数(即我们需要通过训练调整的的值)

x:已知的特征值

b:模型的偏移量

我们的目的是通过已知的x和y,通过训练找出合适的参数w和b来模拟x与y之间的关系,并最终通过x来预测y。

分类:

线性回归属于监督学习中的回归算法;

线性回归作为机器学习的入门级算法,很适合刚接触机器学习的新手。虽然线性回归本身比较简单,但是麻雀虽小,五脏俱全,其中涉及到的“线性模型”、“目标函数”、“梯度下降”、“迭代”、“评价准则”等思想与其他复杂的机器学习算法是相通的,深入理解线性回归后可以帮助你更加轻松的学习其他机器学习算法。

2.线性回归模型解析

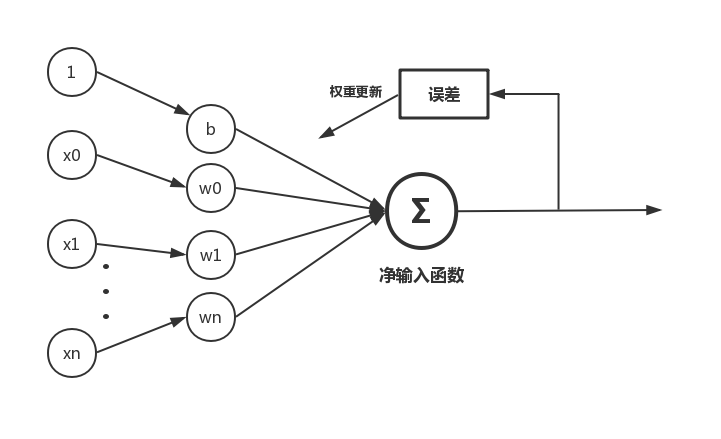

2.1 线性回归模型示意图

2.2模型的组成部件

2.2.1 假设函数(Hypothesis function)

$h_w(x) = b + w_0x_0 + w_1x_1 + ··· +w_nx_n$

使用向量方式表示:

$X=\begin{bmatrix}

\ x_0

\\ x_1

\\\vdots

\\ x_n

\end{bmatrix},W=\begin{bmatrix}

\ w_0

\\ w_1

\\\vdots

\\ w_n

\end{bmatrix}$

则有:$h_w(x) = W^TX+ b$

2.2.2 损失函数:(Cost function)

这里使用平方差作为模型的代价函数

$J(w) = \frac{1}{2m}\sum_{i=1}^{m}(h_w(x^{(i)}) - y^{(i)})^2$

2.2.3 目标函数:(Goal function)

$minimize(J(w))$

2.2.4 优化算法:(optimization algorithm)

梯度下降法(Gradient descent)

关于梯度下降法这里不详细介绍;

3.使用python实现线性回归算法

#-*- coding: utf-8 -*-

import numpy as np

from matplotlib import pyplot as plt #生成训练使用数据;这里线性函数为 y = 1.5*x + 1.3

def data_generate():

#随机生成100个数据

x = np.random.randn(100)

theta = 0.5 #误差系数

#为数据添加干扰

y = 1.5*x + 1.3 + theta*np.random.randn(100)

return x,y class LinearRegression():

'''

线性回归类

参数:

alpha:迭代步长

n_iter:迭代次数

使用示例:

lr = LinearRegression() #实例化类

lr.fit(X_train,y_train) #训练模型

y_predict = lr.predict(X_test) #预测训练数据

lr.plotFigure()用于画出样本散点图与预测模型

'''

def __init__(self,alpha=0.02,n_iter=1000):

self._alpha = alpha #步长

self._n_iter = n_iter #最大迭代次数 #初始化模型参数

def initialPara(self):

#初始化w,b均为0

return 0,0 #训练模型

def fit(self,X_train,y_train):

#保存原始数据

self.X_source = X_train.copy()

self.y_source = y_train.copy() #获取训练样本个数

sample_num = X_train.shape[0]

# 初始化w,w0

self._w, self._b = self.initialPara() #创建列表存放每次每次迭代后的损失值

self.cost = [] #开始训练迭代

for _ in range(self._n_iter):

y_predict = self.predict(X_train)

y_bias = y_train - y_predict

self.cost.append(np.dot(y_bias,y_bias)/(2 * sample_num))

self._w += self._alpha * np.dot(X_train.T,y_bias)/sample_num

self._b += self._alpha * np.sum(y_bias)/sample_num def predict(self,X_test):

return self._w * X_test + self._b #画出样本散点图以及使用模型预测的线条

def plotFigure(self):

#样本散点图

plt.scatter(self.X_source,self.y_source,c='r',label="samples",linewidths=0.4) #模型预测图

x1_min = self.X_source.min()

x1_max = self.X_source.max()

X_predict = np.arange(x1_min,x1_max,step=0.01)

plt.legend(loc='upper left') plt.plot(X_predict,self._w*X_predict+self._b)

plt.show() if __name__ == '__main__':

#创建训练数据

x_data,y_data = data_generate() #使用线性回归类生成模型

lr = LinearRegression()

lr.fit(x_data,y_data) #打印出参数

print(lr._w,lr._b)

#画出损失值随迭代次数的变化图

plt.plot(lr.cost)

plt.show()

#画出样本散点图以及模型的预测图

lr.plotFigure() #预测x

x = np.array([3])

print("The input x is{0},then the predict of y is:{1}".format(x,lr.predict(x)))

线性回归代码

更多线性回归的代码参考github:线性回归

最新文章

- 内外分离接口依赖及UIScrollView知识点

- Delphi中的各种字符串、String、PChar、Char数组

- PBR综合小实验视频-狮子XL

- 查单神器v1.0 升级 →B站看鬼畜神器v1.0

- 安装VS2015可能出现的问题以及解决方法

- 根据关键词获取进程ID然后杀掉进程

- 20分钟入门Redux

- python BeautifulSoup find 方法

- Ubuntu设置目录的读写权限(Linux命令chmod 777 dirName)

- The Angles of a Triangle

- react基础学习

- Android studio安装和问题

- Android广播的发送与接收

- 解决win10 64位 + Python3 安装PyAutoIt报不是有效win32应用程序的办法

- 57.搭建Vue环境

- is,as,类库

- 使用U盘为虚拟机安装系统

- leetcode python 001

- idea中Eclipse Code Formatter插件设置和使用,以及注释模板的修改

- hdu 5038 水题 可是题意坑