理解Spark运行模式(二)(Yarn Cluster)

上一篇说到Spark的yarn client运行模式,它与yarn cluster模式的主要区别就是前者Driver是运行在客户端,后者Driver是运行在yarn集群中。yarn client模式一般用在交互式场景中,比如spark shell, spark sql等程序,但是该模式下运行在客户端的Driver与Yarn集群有大量的网络交互,如果客户端与集群之间的网络不是很好,可能会导致性能问题。因此一般在生产环境中,大部分还是采用yarn cluster模式运行spark程序。

下面具体还是用计算PI的程序来说明,examples中该程序有三个版本,分别采用Scala、Python和Java语言编写。本次用Python程序pi.py做说明。

from __future__ import print_function import sys

from random import random

from operator import add from pyspark.sql import SparkSession if __name__ == "__main__":

"""

Usage: pi [partitions]

"""

spark = SparkSession\

.builder\

.appName("PythonPi")\

.getOrCreate() partitions = int(sys.argv[1]) if len(sys.argv) > 1 else 2

n = 100000 * partitions def f(_):

x = random() * 2 - 1

y = random() * 2 - 1

return 1 if x ** 2 + y ** 2 <= 1 else 0 count = spark.sparkContext.parallelize(range(1, n + 1), partitions).map(f).reduce(add)

print("Pi is roughly %f" % (4.0 * count / n)) spark.stop()

程序逻辑与上一篇Scala程序一样,就不再多做说明了。

下面来以yarn cluster方式来执行这个程序,注意执行程序前先要启动hdfs和yarn,最好同时启动spark的history server,这样即使在程序运行完以后也可以从Web UI中查看到程序运行情况。

输入以下命令:

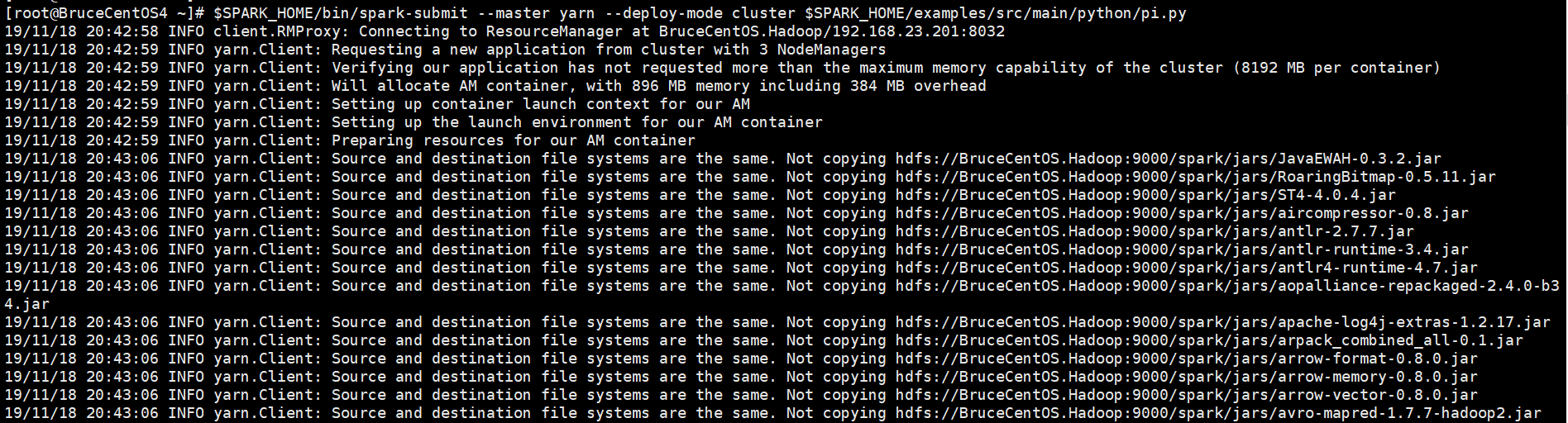

[root@BruceCentOS4 ~]# $SPARK_HOME/bin/spark-submit --master yarn --deploy-mode cluster $SPARK_HOME/examples/src/main/python/pi.py

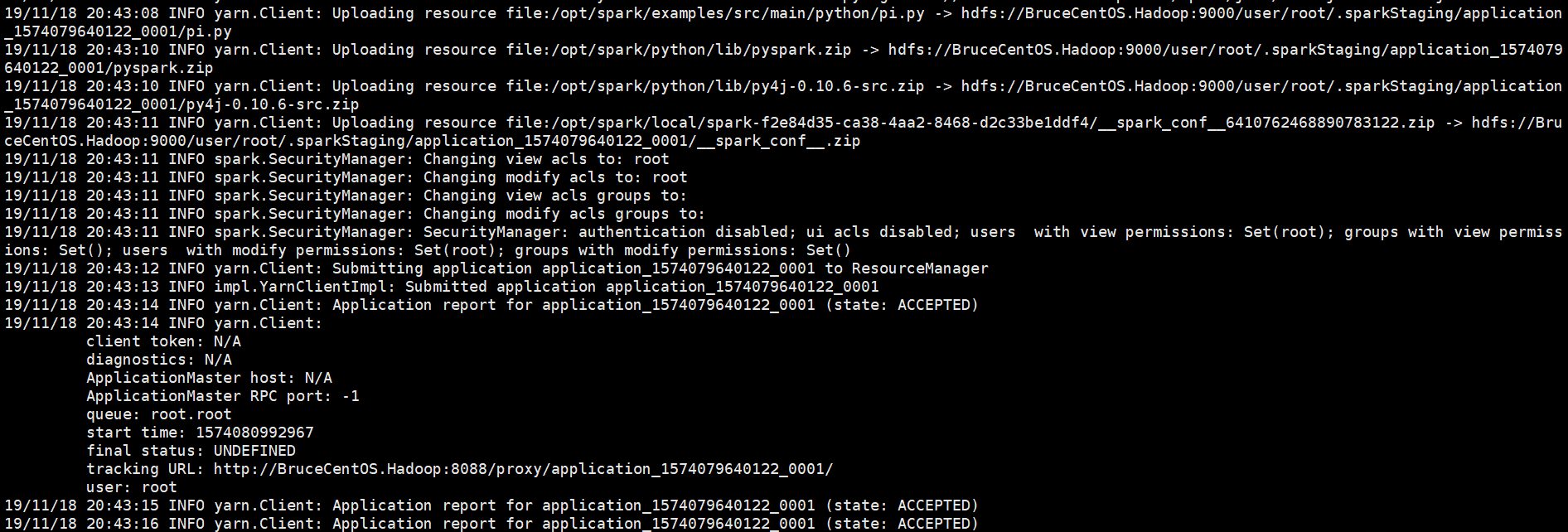

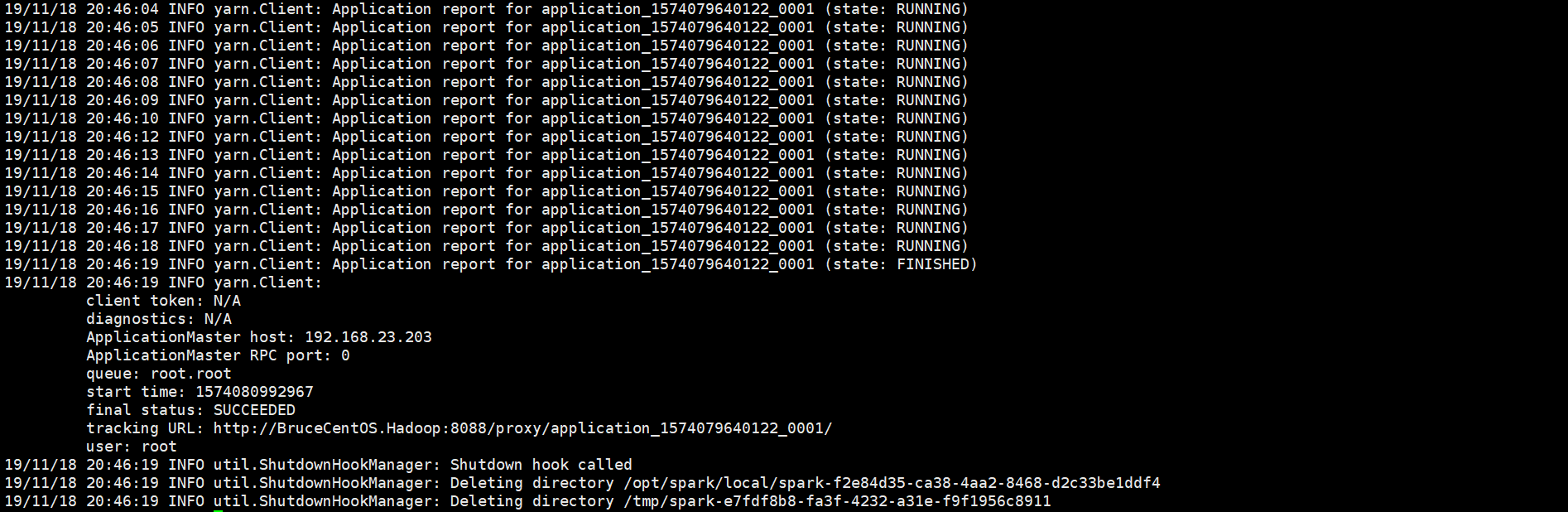

以下是程序运行输出信息部分截图,

开始部分:

中间部分:

结束部分:

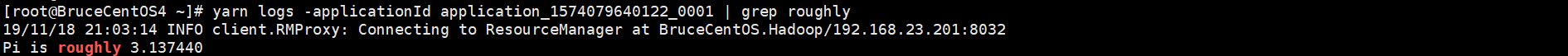

由于程序是以yarn cluster方式运行的,因此Driver是运行在Yarn集群当中(在BruceCentOS3上的ApplicationMaster进程当中),同时在BruceCentOS和BruceCentOS2上各运行了1个Executor进程(进程名字:CoarseGrainedExecutorBackend),而BruceCentOS4上的SparkSubmit进程仅仅作为yarn client向yarn集群提交spark程序。作为对比,在yarn client模式当中,客户端SparkSubmit进程不仅作为yarn client提交程序,而且同时还会运行Driver,并启动SparkContext,并且向Executor分配和管理Task,最后收集运行结果,因此yarn client模式程序输出信息会显示最终的打印结果。然而在yarn cluster模式当中,由于Driver运行在yarn集群的ApplicationMaster中,因此最终结果需要到ApplicationMaster进程的日志中取查看。可以通过如下命令查看。

SparkUI上的Executor信息:

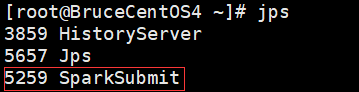

BruceCentOS4上的客户端进程:

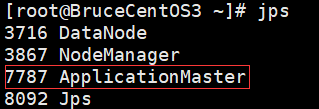

BruceCentOS3上的ApplicationMaster进程(包含Spark Driver):

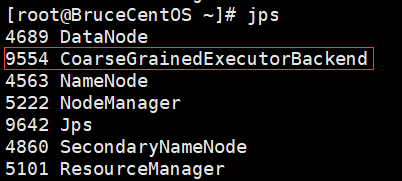

BruceCentOS上的Executor:

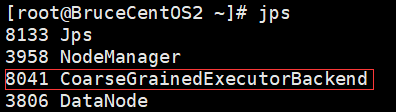

BruceCentOS2上的Executor:

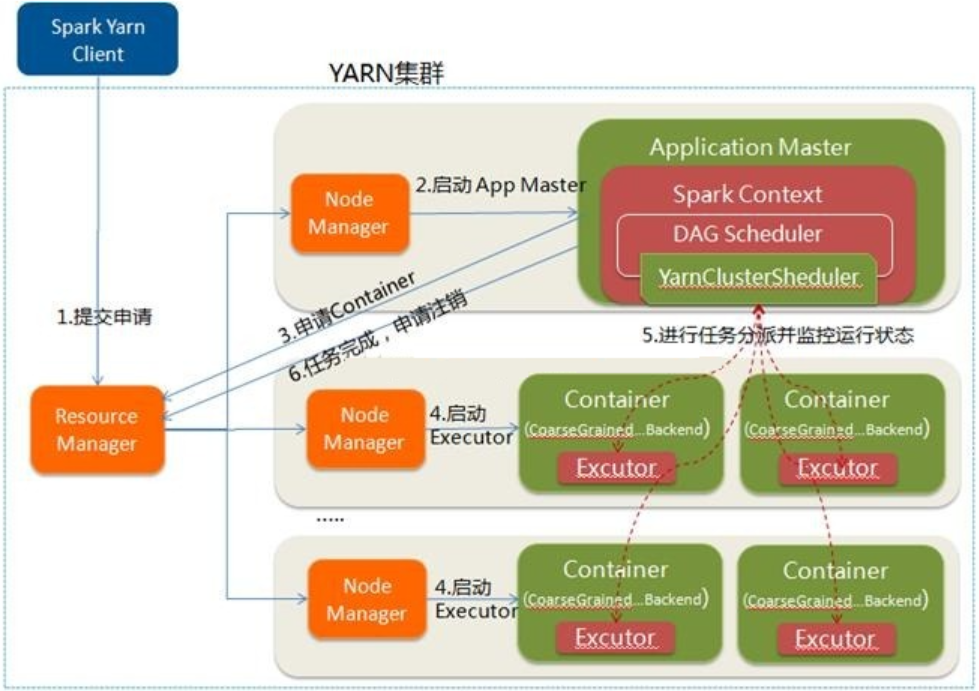

下面具体描述下Spark程序在yarn cluster模式下运行的具体流程。

这里是一个流程图:

- Spark Yarn Client向YARN提交应用程序,类似于MapReduce向Yarn提交程序,会将程序文件、库文件和配置文件等上传到HDFS。

- ResourceManager收到请求后,在集群中选择一个NodeManager,为该应用程序分配第一个Container,要求它在这个Container中启动应用程序的ApplicationMaster,其中ApplicationMaster中会运行Spark Driver,并进行SparkContext的初始化。

- ApplicationMaster向ResourceManager注册,这样用户可以直接通过ResourceManager查看应用程序的运行状态,然后它将采用轮询的方式通过RPC协议为各个任务申请资源,并监控它们的运行状态直到运行结束。

- 一旦ApplicationMaster申请到资源(也就是Container)后,便与对应的NodeManager通信,要求它在获得的Container中启动CoarseGrainedExecutorBackend,CoarseGrainedExecutorBackend启动后会向ApplicationMaster中的SparkContext注册并申请Task。这一点和Standalone模式一样,只不过SparkContext在Spark Application中初始化时,使用CoarseGrainedSchedulerBackend配合YarnClusterScheduler进行任务的调度。

- ApplicationMaster中的SparkContext分配Task给CoarseGrainedExecutorBackend执行,CoarseGrainedExecutorBackend运行Task并向ApplicationMaster汇报运行的状态和进度,以让ApplicationMaster随时掌握各个任务的运行状态,从而可以在任务失败时重新启动任务。

- 应用程序运行完成后,ApplicationMaster向ResourceManager申请注销并关闭自己。

以上就是个人对Spark运行模式(yarn cluster)的一点理解,其中参考了“求知若渴 虚心若愚”博主的“Spark(一): 基本架构及原理”的部分内容(其中基于Spark2.3.0对某些细节进行了修正),在此表示感谢。

最新文章

- const 与 readonly知多少

- tab22

- 如何将matlab画出的图片保存为要求精度

- SGU326 Perspective(指派问题)

- 通过运行时动态给OC分类添加属性

- android中发送邮件

- hdu2795--Billboard

- Android 开发笔记___RelativeLayout

- jquery实现上传图片本地预览效果

- CentOS7 配置ISCSI targetcli 共享存储

- Linux查找文件、文件夹

- 【c++基础】遍历目录并写入txt文件-linux

- 20155239 2016-2017-2 《Java程序设计》第5周学习总结

- Python 入门(四)List和Tuple类型

- Form中的keypress事件不能用

- Access的"是否型"字段与Sql Server的"Bit"字段

- bzoj2054: 疯狂的馒头(并查集)

- ZooKeeper在线迁移

- BootStrap的table表格的基本写法

- jsp页面form表单提交时候乱码

热门文章

- CSS中各种布局的背后(*FC)

- spring boot 2.x文件路径映射问题汇总

- HDU 3371 Connect the Cities(并查集+Kruskal)

- liunux中的标准输出。以及常用的 2>dev/null 命令的含义

- 开源造轮子:一个简洁,高效,轻量级,酷炫的不要不要的canvas粒子运动插件库

- 玩转OneNET物联网平台之MQTT服务④ —— 远程控制LED(设备自注册)+ Android App控制

- maven 打包 spring boot 生成docker 镜像

- JAVA实现扫描线算法

- IntelliJ IDEA 2019.2最新版本免费激活码

- os模块/sys模块/json/pickle模块/logging模块(day16整理)