理解Spark运行模式(三)(STANDALONE和Local)

前两篇介绍了Spark的yarn client和yarn cluster模式,本篇继续介绍Spark的STANDALONE模式和Local模式。

下面具体还是用计算PI的程序来说明,examples中该程序有三个版本,分别采用Scala、Python和Java语言编写。本次用Java程序JavaSparkPi做说明。

package org.apache.spark.examples; import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.sql.SparkSession; import java.util.ArrayList;

import java.util.List; /**

* Computes an approximation to pi

* Usage: JavaSparkPi [partitions]

*/

public final class JavaSparkPi { public static void main(String[] args) throws Exception {

SparkSession spark = SparkSession

.builder()

.appName("JavaSparkPi")

.getOrCreate(); JavaSparkContext jsc = new JavaSparkContext(spark.sparkContext()); int slices = (args.length == 1) ? Integer.parseInt(args[0]) : 2;

int n = 100000 * slices;

List<Integer> l = new ArrayList<>(n);

for (int i = 0; i < n; i++) {

l.add(i);

} JavaRDD<Integer> dataSet = jsc.parallelize(l, slices); int count = dataSet.map(integer -> {

double x = Math.random() * 2 - 1;

double y = Math.random() * 2 - 1;

return (x * x + y * y <= 1) ? 1 : 0;

}).reduce((integer, integer2) -> integer + integer2); System.out.println("Pi is roughly " + 4.0 * count / n); spark.stop();

}

}

程序逻辑与之前的Scala和Python程序一样,就不再多做说明了。对比Scala、Python和Java程序,同样计算PI的逻辑,程序分别是26行、30行和43行,可以看出编写Spark程序,使用Scala或者Python比Java来得更加简洁,因此推荐使用Scala或者Python编写Spark程序。

下面来以STANDALONE方式来执行这个程序,执行前需要启动Spark自带的集群服务(在master上执行$SPARK_HOME/sbin/start-all.sh),最好同时启动spark的history server,这样即使在程序运行完以后也可以从Web UI中查看到程序运行情况。启动Spark的集群服务后,会在master主机和slave主机上分别出现Master守护进程和Worker守护进程。而在Yarn模式下,就不需要启动Spark的集群服务,只需要在客户端部署Spark即可,而STANDALONE模式需要在集群每台机器都部署Spark。

输入以下命令:

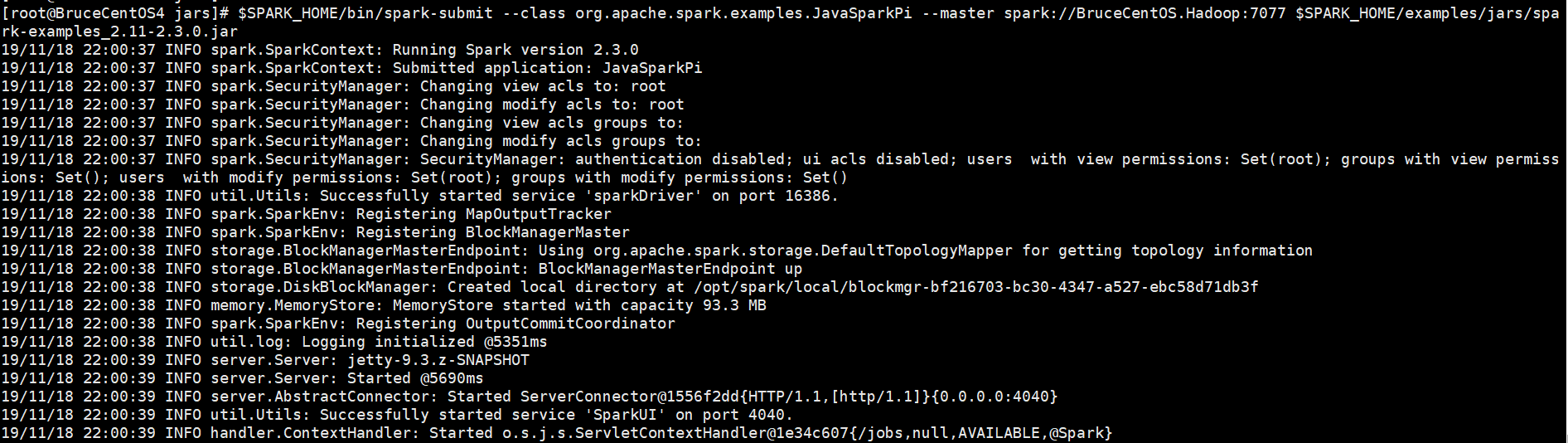

[root@BruceCentOS4 jars]# $SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master spark://BruceCentOS.Hadoop:7077 $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

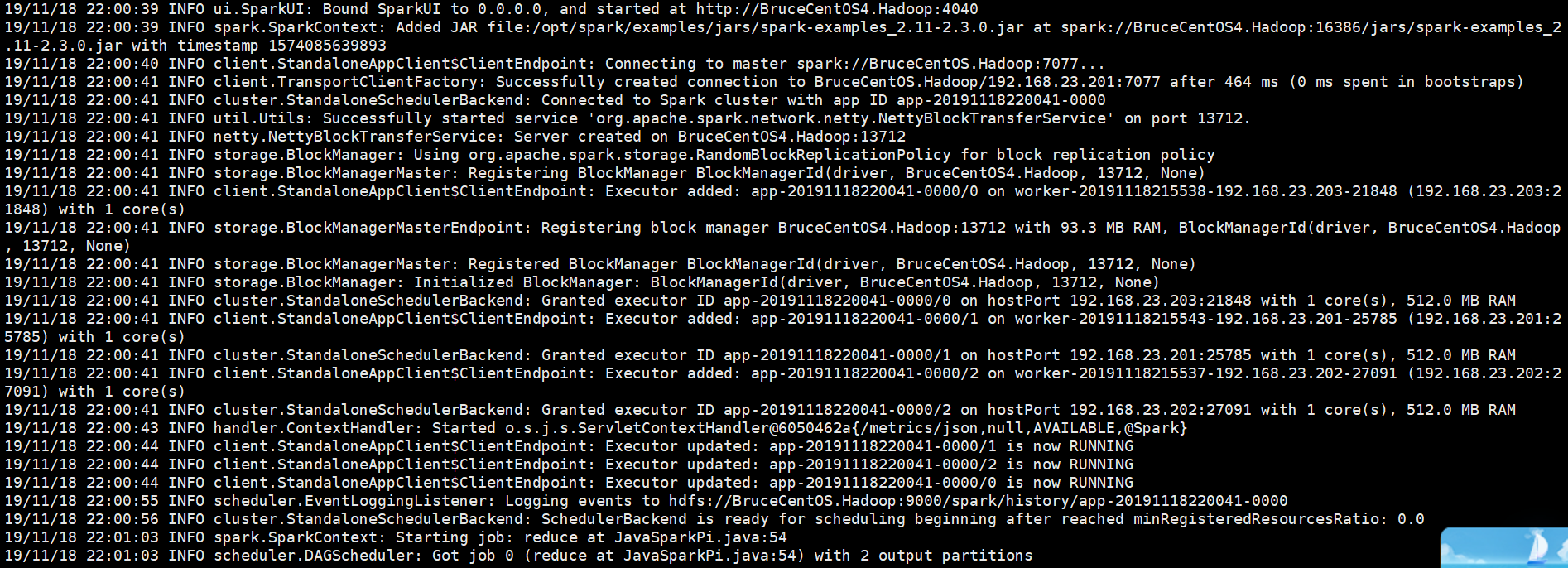

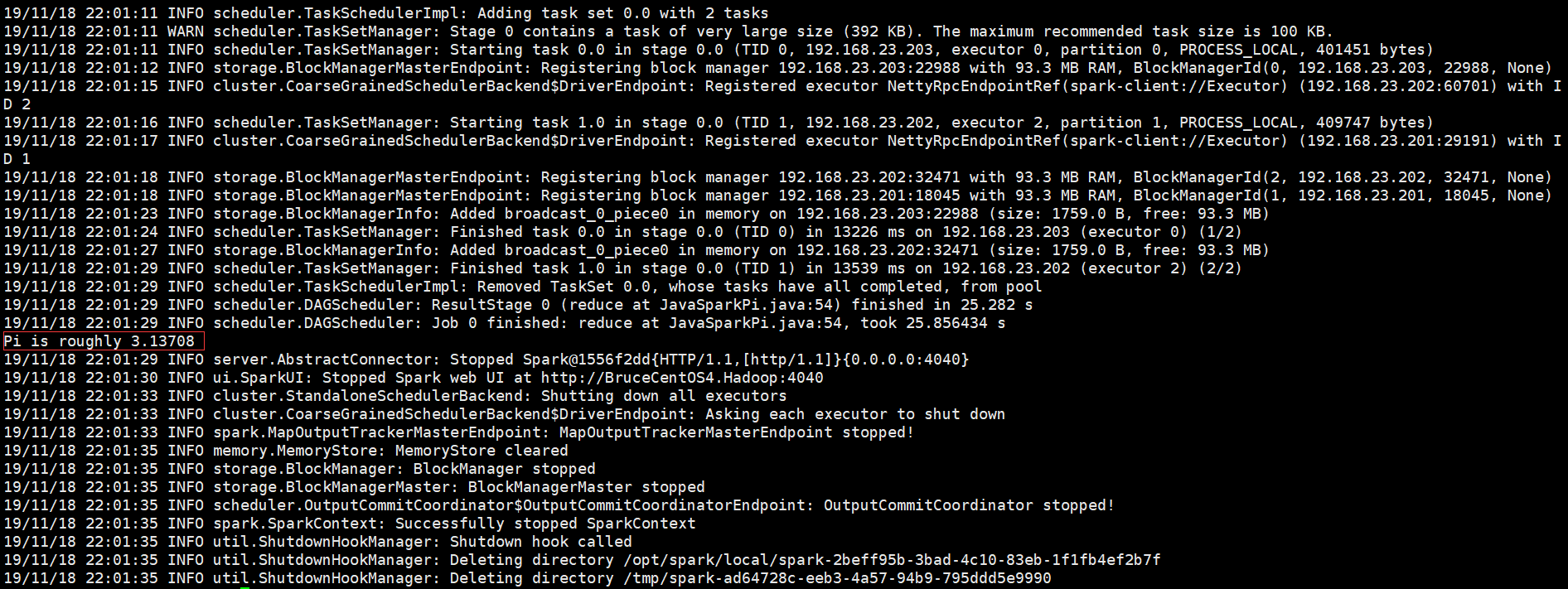

以下是程序运行输出信息部分截图,

开始部分:

中间部分:

结束部分:

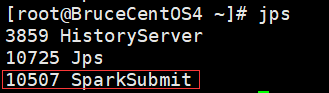

从上面的程序输出信息科看出,Spark Driver是运行在客户端BruceCentOS4上的SparkSubmit进程当中的,集群是Spark自带的集群。

SparkUI上的Executor信息:

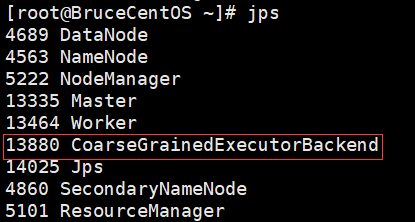

BruceCentOS4上的客户端进程(包含Spark Driver):

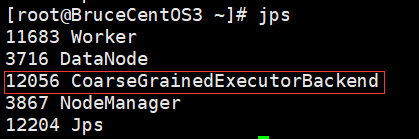

BruceCentOS3上的Executor进程:

BruceCentOS上的Executor进程:

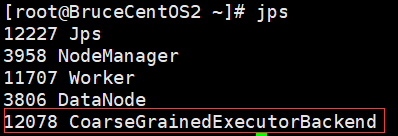

BruceCentOS2上的Executor进程:

下面具体描述下Spark程序在standalone模式下运行的具体流程。

这里是一个流程图:

- SparkContext连接到Master,向Master注册并申请资源(CPU Core 和Memory)。

- Master根据SparkContext的资源申请要求和Worker心跳周期内报告的信息决定在哪个Worker上分配资源,然后在该Worker上获取资源,然后启动CoarseGrainedExecutorBackend。

- CoarseGrainedExecutorBackend向SparkContext注册。

- SparkContext将Applicaiton代码发送给CoarseGrainedExecutorBackend;并且SparkContext解析Applicaiton代码,构建DAG图,并提交给DAG Scheduler分解成Stage(当碰到Action操作时,就会催生Job;每个Job中含有1个或多个Stage,Stage一般在获取外部数据和shuffle之前产生),然后以Stage(或者称为TaskSet)提交给Task Scheduler,Task Scheduler负责将Task分配到相应的Worker,最后提交给CoarseGrainedExecutorBackend执行。

- CoarseGrainedExecutorBackend会建立Executor线程池,开始执行Task,并向SparkContext报告,直至Task完成。

- 所有Task完成后,SparkContext向Master注销,释放资源。

最后来看Local运行模式,该模式就是在单机本地环境执行,主要用于程序测试。程序的所有部分,包括Client、Driver和Executor全部运行在客户端的SparkSubmit进程当中。Local模式有三种启动方式。

#启动1个Executor运行任务(1个线程)

[root@BruceCentOS4 ~]#$SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master local $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

#启动N个Executor运行任务(N个线程),这里N=2

[root@BruceCentOS4 ~]#$SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master local[2] $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

#启动*个Executor运行任务(*个线程),这里*指代本地机器上的CPU核的个数。

[root@BruceCentOS4 ~]#$SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master local[*] $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

以上就是个人对Spark运行模式(STANDALONE和Local)的一点理解,其中参考了“求知若渴 虚心若愚”博主的“Spark(一): 基本架构及原理”的部分内容(其中基于Spark2.3.0对某些细节进行了修正),在此表示感谢。

最新文章

- [转]MSI安装程序中的文件替换

- SQLServer根据日期查询星期

- 强制SQL Server执行计划使用并行提升在复杂查询语句下的性能

- WordPress使用固定链接

- 数据库中Schema(模式)概念的理解

- hdu 2075

- C#中sealed关键字

- 学习使用Free RTOS ,移植最新的STM32 v3.5固件库

- java axis web service

- Ext JS学习第十天 Ext基础之 扩展原生的javascript对象(二)

- c#多选下拉框(ComboBox)

- Jmeter(四)-断言/检查点

- 201521123028 《Java程序设计》第14周学习总结

- Python+Selenium+PIL+Tesseract真正自动识别验证码进行一键登录

- Eclipse工具:常用快捷键记录

- Git学习笔记--命令

- Golang 容器和不同header的解析

- Python 统计代码量

- 如何开启mysql5.5的客户端服务 命令行打开方法

- Cocos2dx Label