Hadoop-2.4.1 ubuntu集群安装配置教程

一.环境

系统: Ubuntu 14.04 32bit

Hadoop版本: Hadoop 2.4.1 (stable)

JDK版本: 1.7

集群数量:3台

注意事项:我们从Apache官方网站下载的Hadoop2.4.1是linux32位系统可执行文件,所以如果需要在64位系统上部署则需要单独下载src 源码自行编译。

二.准备工作

(三台机器都需要进行以下前四步配置)

1.安装ubuntu14.04 32bits

2.创建新用户hadoop并增加管理员权限

输入如下命令(整个hadoop配置最好切换到root权限进行,在ubuntu下使用root必须给root设置密码才可使用:sudo passwd root):

root@ubuntu:~# sudo adduser hadoop

按照提示输入信息,密码设置为hadoop,回车确定。结束之后系统会自动创建用户主目录,创建用户同名的组。(adduser命令包装了useradd,虽然在别的linux系统下两个命令一样,但在ubuntu下使用useradd时,并没有创建同名的用户主目录。)

让该用户获得管理员权限:

hadoop@ubuntu:~# sudo vim /etc/sudoers

修改文件如下:

# User privilege specification

root ALL=(ALL) ALL

hadoop ALL=(ALL) ALL

保存退出,hadoop用户就拥有了root权限。

3.安装jdk(安装完之后用java -version查看jdk版本)

已经下载好java安装包,根据安装教程进行安装

4.修改机器网络配置

修改机器的hostname为Master,Slave1,Slave2(对应三台机器):

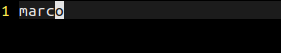

hadoop@ubuntu:~# sudo vim /etc/hostname

(marco对应为Master,Slave1,Slave2)

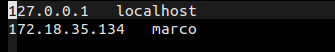

三台机器的IP必须固定。修改hosts文件。

hadoop@ubuntu:~# sudo vim /etc/hosts

添加字段:IP hostname

(marco对应为Master,Slave1,Slave2)

完成后重启机器,然后在终端可以看到hostname的变化。

(配置完之后可以互相ping主机名测试是否配置成功)

5.配置SSH无密码登陆

安装ssh(如果系统没有默认安装或者版本过旧使用以下命令,确保三台机器都有ssh服务)

hadoop@Master:~# sudo apt-get install ssh

生成Master的公钥:

hadoop@Master:~# cd ~/.ssh

hadoop@Master:~# ssh-keygen -t rsa # 一直按回车就可以,生成的密钥保存为.ssh/id_rsa

Master 节点需能无密码 ssh 本机,这一步还是在 Master 节点上执行:

hadoop@Master:~# cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

(完成后可以用ssh Master验证)

接着将公匙传输到 Slave1(Slave2) 节点:

hadoop@Master:~# scp ~/.ssh/id_rsa.pub hadoop@Slave1:/home/hadoop/

然后在Slave1节点上将ssh公钥保存到相应位置:

hadoop@Slave1:~# cat ~/id_rsa.pub >> ~/.ssh/authorized_keys

最后在Master节点就可以无密码ssh到Slave1(Slave2)了。

三.配置集群/分布式环境

1.下载并解压hadoop-2.4.1.tar.gz文件在/home/hadoop目录下。(在Master下配置,之后再将配置传输到slave节点)

2.修改文件slaves

hadoop@Master:~# cd /home/hadoop/etc/hadoop/

hadoop@Master:~# vim slaves

将原来 localhost 删除,把所有Slave的主机名写上,每行一个。如下:

Slave1

Slave2

3.修改文件core-site.xml

将原来的如下内容

<property>

</property>

改为下面的配置。后面的配置文件的修改类似。

<property>

<name>fs.defaultFS</name>

<value>hdfs://Master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/home/hadoop/hadoopInfo/tmp</value>

</property>

(如果启动服务时找不到hadoopInfo/tmp,需手动在三台机器创建该目录)

4.修改hdfs-site.xml

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/hadoop/hadoopInfo/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/hadoop/hadoopInfo/tmp/dfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

5.修改文件mapred-site.xml,这个文件不存在,首先需要从模板中复制一份:

hadoop@Master:~# cp mapred-site.xml.template mapred-site.xml

然后配置修改如下:

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

6.修改文件yarn-site.xml:

<property>

<name>yarn.resourcemanager.hostname</name>

<value>Master</value>

</property>

7.配置好后,将 Master 上的 Hadoop 文件复制到各个节点上(虽然直接采用 scp 复制也可以正确运行,但会有所不同,如符号链接 scp 过去后就有点不一样了。所以先打包再复制比较稳妥)。

hadoop@Master:~# cd /home/hadoop

hadoop@Master:~# sudo tar -zcf ./hadoop-2.4.1.tar.gz ./hadoop-2.4.1

hadoop@Master:~# scp ./hadoop-2.4.1.tar.gz Slave1:/home/hadoop

在Slave1(Slave2)上执行:

hadoop@Slave1:~# sudo tar -zxf ~/hadoop-2.4.1.tar.gz

hadoop@Slave1:~# sudo chown -R hadoop:hadoop /home/hadoop

注意事项:切换 Hadoop 的模式,不管是从集群切换到伪分布式,还是从伪分布式切换到集群,如果遇到无法正常启动的情况,可以删除所涉及节点的临时文件夹,这样虽然之前的数据会被删掉,但能保证集群正确启动。或者可以为集群模式和伪分布式模式设置不同的临时文件夹(未验证)。所以如果集群以前能启动,但后来启动不了,特别是 DataNode 无法启动,不妨试着删除所有节点(包括 Slave 节点)上的 tmp 文件夹,重新执行一次 bin/hdfs namenode -format,再次启动试试。

8.然后在Master节点上就可以启动hadoop了。

hadoop@Master:~# cd /home/hadoop/hadoop-2.4.1

hadoop@Master:~# bin/hdfs namenode -format # 首次运行需要执行初始化,后面不再需要

hadoop@Master:~# sbin/start-dfs.sh

hadoop@Master:~# sbin/start-yarn.sh

通过命令JPS可以查看各个节点所启动的过程。

可以看到Master节点启动了NameNode、SecondrryNameNode、ResourceManager进程。

Slave节点则启动了DataNode和NodeManager进程。

可以通过http://master:50070/进入hadoop的管理界面。

关闭Hadoop集群也是在Master节点上执行:

hadoop@Master:~# sbin/stop-dfs.sh

hadoop@Master:~# sbin/stop-yarn.sh

四.应用案例:

在官网上有一个hadoop单节点和集群的hadoop job示例,

http://hadoop.apache.org/docs/r1.2.1/mapred_tutorial.html

根据链接里的 Example: WordCount v2.0 部分进行操作

最新文章

- 黑马程序员:Java编程_基础语法

- python 数据库 blob类型 转字符串

- C++ map的使用

- 我的Android最佳实践之—— 常用的Intent.Action(转)

- ASP.NET内置对象一

- Selenium - IDE模式匹配

- 计算机视觉与模式识别代码合集第二版three

- 浅谈javascript性能-管理内存

- 硅谷创业教父Paul Graham:如何获得创业idea

- 使用Homebrew配置Java开发环境

- Java经验杂谈(2.对Java多态的理解)

- Markdown 语法详尽笔记大全 2019

- 【Oracle】【9】阅读oracle执行计划

- 大数据小白系列——MR(1)

- 【awk】提取文件第一列

- hdu 5126 stars (四维偏序,离线,CDQ套CDQ套树状数组)

- iOS耳机等音频输出设备切换的通知

- Pycharm(五)安装库和虚拟环境

- 一种基于zookeeper的分布式队列的设计与实现

- linux下安装oracle需要的配置